(追記) ChatGPT関連のショートカットの「codex」というアクションについての追加質問を本記事の最後に追記。

iPhoneで使用できるショートカットは、アクションと呼ばれる処理単位を組み合わせて、処理の自動化を図るものだが、AI関連のアクションもあるようなので、今回はこれらのアクションについて調べることにした。ただし、その前に、各AIがショートカットのアクションについてどの程度知っているかを、1例ではあるが確かめることにした。

具体的には、アクションを設定した画面の画像を各AIに見せて、アクションの名称、アクションの設定手順を説明してもらうことにした。自分で作成したショートカットでも、どのアクションを使ったのか忘れてしまうことがあり、アクションを配置した設定画面を見ても、アクションの名称をすぐには思い出せないことがある。

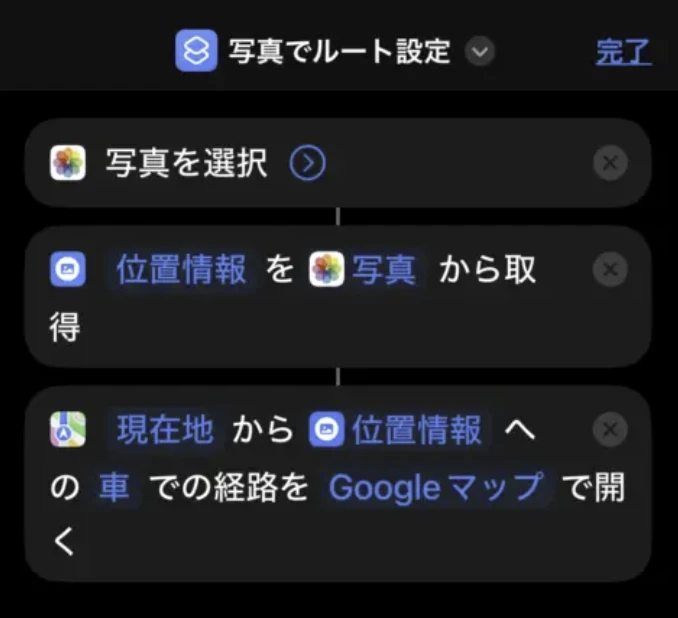

使用するショートカットは、写真の位置情報を入手して、その位置情報が示す位置までの経路をGoogleマップに設定するというものであり、設定画面は下図のものである。

添付画像は、iPhoneのショートカットの設定画面です。使っているアクション、設定手順は分かりますか

(注)本記事の内容は正確性を保証するものではない。

各AIの回答

| AI | 回答(抜粋) |

|---|---|

| GPT 5 Thinking | はい、分かります!画像のショートカットは次の3アクションで構成されています。 写真を選択 フォトライブラリから写真を1枚選びます(複数選択はオフ推奨)。 位置情報を[写真]から取得 1)で選んだ写真のEXIFから緯度経度(場所)を取り出します。 位置情報が無い写真だと次の手順でエラー/未指定になります。 現在地から[位置情報]への経路を Googleマップで開く(車) 出発地:現在地 目的地:2)で取得した「位置情報」 移動手段:車 マップアプリ:Google マップ(ここを「Apple マップ」にも変更可) 作り方(手順) ショートカットを新規作成し、名前を付ける(例:写真でルート設定)。 検索で「写真を選択」を追加。 続けて「位置情報を取得」を追加し、対象を「写真」に設定(自動で前の出力が入ります)。 「経路を開く」(または「経路を表示」)アクションを追加。 出発地=現在地、目的地=位置情報を指定 交通手段=車 Google マップを選択(青字部分をタップして切替) |

| Perplexity Pro | はい、この画像はiPhoneのショートカットアプリで作成された「写真から目的地設定し、Googleマップでルート案内する」ショートカットの設定画面です。使っているアクションや手順は以下の通りです。 使っているアクション 写真を選択 「写真」から位置情報を取得 現在地から取得した位置情報まで車での経路をGoogleマップで開く 設定手順の概要 「写真を選択」アクション:写真ライブラリから好きな写真を選ぶ。 「位置情報を取得」アクション:選んだ写真に埋め込まれている位置情報(GPSデータ)を取得する。 「経路を開く」アクション:現在地から上記の位置情報(写真の撮影場所)までのルートを、Googleマップで「車」モードで表示する。 このショートカットを使うと、iPhoneの写真に付与されている位置情報をワンタップで目的地に設定し、Googleマップで道順をすぐに確認できます。 |

| Gemini 2.5 Flash | 添付の画像は、iPhoneのショートカットの設定画面です。 画像から読み取れる使われているアクションと設定手順は以下の通りです。 使われているアクション 「写真を選択」: 端末内の写真から1枚を選択します。 「位置情報 を 写真 から取得」: 選択した写真に付与されている位置情報(GPSデータ)を取得します。 「現在地 から 位置情報 への車での経路を Google マップ で開く」: 端末の現在地から、写真から取得した位置情報までの自動車での経路をGoogleマップで開きます。 設定手順 iPhoneの「ショートカット」アプリを開きます。 新規ショートカットを作成します。 検索バーで「写真」と入力し、「写真を選択」アクションを追加します。 次に、再度検索バーで「位置情報」と入力し、「位置情報を写真から取得」アクションを追加します。この際、前のステップで選択した写真の情報が自動的に次のアクションの入力として渡されます。 最後に、検索バーで「マップ」と入力し、「現在地から…への経路を…で開く」アクションを追加します。この際、前のステップで取得した位置情報が自動的に目的地として設定されます。また、経路の手段が「車」に、開くアプリが「Googleマップ」に設定されていることを確認します。 このショートカットは、写真に記録された撮影場所まで、現在地からGoogleマップを使って自動車で移動する経路を素早く検索・表示するために作成されたものと考えられます。 |

ポイントは、2つ目のアクション「写真から位置情報を取得する」である。どのAIも、添付画像に表示された文字列から、このアクションの名称を、上記回答の赤字で示した名称として回答しているが間違っている。

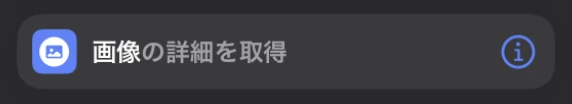

正解は、「画像の詳細を取得」である。そのアクションの詳細設定画面で「位置情報」を選択することになる。

回答が間違っていたので、各AIに、回答してもらった2つ目のアクションについて、そのような名称のアクションはない旨伝え、正しい名称が分からないか質問した。

各AIの回答

| AI | 回答(抜粋) |

|---|---|

| GPT 5 Thinking | ご指摘の通り、「位置情報を取得」という名前のアクションはありません。 スクショの2段目は「メディアの詳細を取得」(iOSのバージョンによっては「写真の詳細を取得」/「イメージの詳細を取得」と表示)です。 追加後、取得する詳細=「位置情報」 を選択 入力=「写真」(直前の「写真を選択」の出力)が入るようにします これで「写真のEXIFにある緯度・経度(位置情報)」が取り出され、次の「経路を開く」で目的地に渡せます。 もし検索で見つからない場合は、アクション検索欄に「詳細」「メディア」「写真 詳細」などと入れて探してください。 |

| Perplexity Pro | ショートカットの「位置情報を取得」という名称のアクションは実際には存在しません。この画像で使われているのは「メディアから詳細を取得」というアクション(英語名:Get Details of Media)です。lala-coms 正しいアクション名 「詳細を取得」または「メディアから詳細を取得」 写真を選択後、「詳細を取得」アクションで「位置情報」の属性を指定すると、写真に保存されているGPS情報(位置情報)が取得できます。iphone-mania 設定手順のポイント 「写真を選択」アクションを追加。 「メディアから詳細を取得」アクション(項目で「位置情報」を選択)を追加。 取得した位置情報を目的地に設定して、Googleマップで経路を開く。 「位置情報を取得」と表示されている箇所は、この「メディアから詳細を取得」アクションの「取得する詳細」を「位置情報」に設定した状態を示しています。lala-coms |

| Gemini 2.5 Flash | 申し訳ありません、私の以前の回答に誤りがありました。「位置情報を写真から取得」という名前のアクションは存在しません。 添付画像から読み取れる正確なアクション名は以下の通りです。 「位置情報 を 写真 から 取得」 これは、ショートカットアプリの画面上で、アクションの名前が途中で改行されたり、文字が省略されたりして表示されているために生じた誤解です。実際のアクションは、「写真の詳細を取得」という名前で、そのオプションで「位置情報」を選択するものです。 したがって、画像に表示されているショートカットは、以下の3つのアクションで構成されています。 写真を選択 写真の詳細を取得(「位置情報」を指定) 現在地からの経路(Googleマップで開く) |

アクションの名称が違っていることを伝えると、どのAIも、そこそこ近い名称を回答した。

実際は、アクションの検索画面で、「写真」、「詳細」、「取得」のいずれかのキーワードを入力すれば、「画像の詳細を取得」も表示されるのだが、「位置」というキーワードでは表示されなかった。何でもないことだが、思い込むと意外とはまるものである。

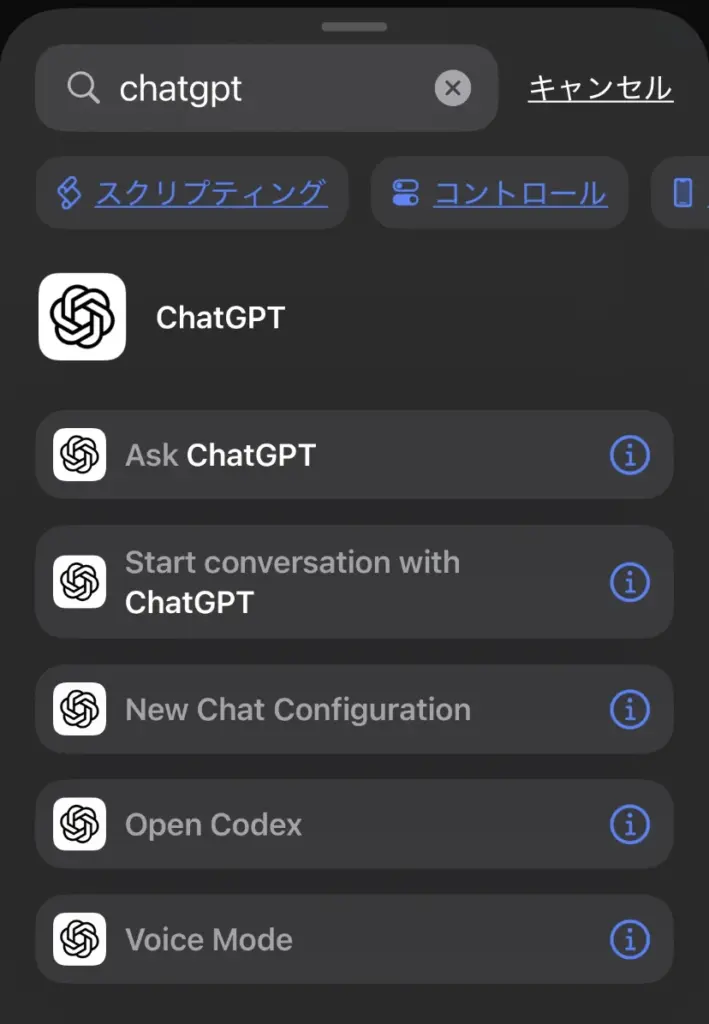

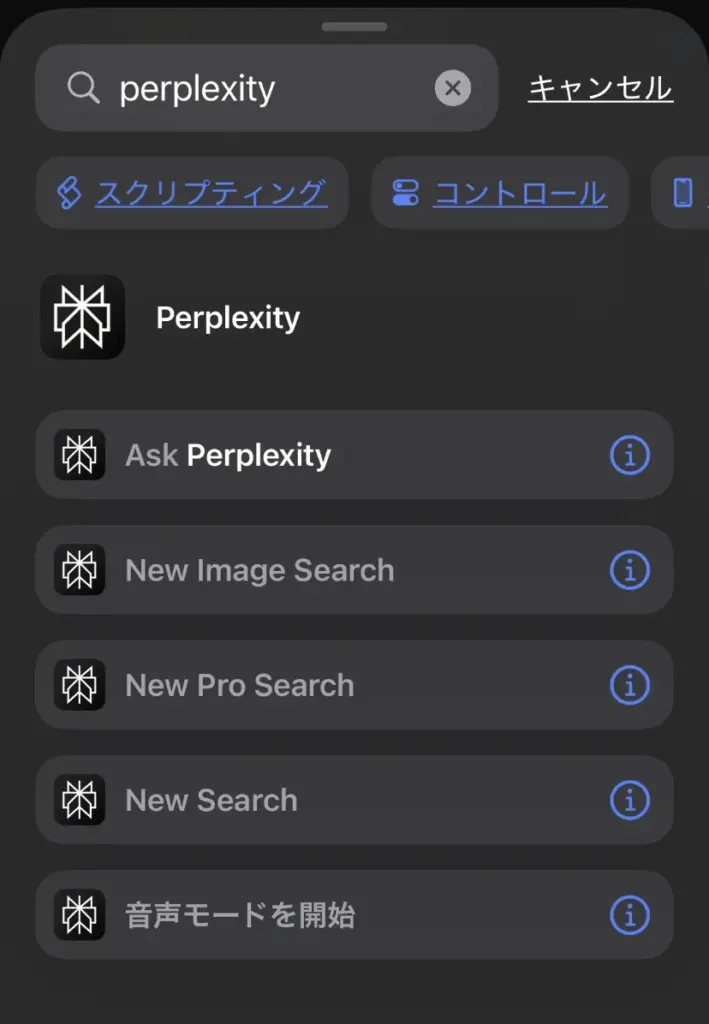

次に、AI関連のアクションについて調べた。

添付画像は、iPhoneで使えるショートカットのアクションの一部です。AI関連のアクションを集めてみました。各アクションについて、機能・使用例を教えてください

GPT 5 Thinking の回答

| AI | 回答(抜粋) |

|---|---|

| ChatGPT | Ask ChatGPT 機能:テキストをChatGPTに投げて回答テキストを受け取る。汎用。 使用例: 共有シートで選んだPDFのテキスト → 「100文字で要約」→ メール本文に挿入。 音声入力のメモ → 「敬体に整えて」→ メッセージで共有。 Start conversation with ChatGPT 機能:ChatGPTの新規チャット画面(またはアプリ内の会話)を起動。対話開始をショートカットから。 使用例: 「アイデアブレスト」ショートカット→ このアクション → アプリで即会話。 New Chat Configuration 機能:新規チャットの設定(トーン/目的等)を指定して開始(アプリ側が用意するテンプレやモードを選ぶ用途)。 使用例: 「ブログ下書きモードで開始」→ その後の共有シートから素材を渡して流れ作成。 Open Codex 機能:ChatGPTアプリ内のコード支援(Codex的機能/開発向けビュー)を開く導線。 使用例: クリップボードのエラーログ → このアクション → コード修正提案を得て メモに保存。 Voice Mode 機能:ChatGPTの音声モードを起動。会話の聞き取り・読み上げ対応。 使用例: 運転前に「今日の予定をかんたんに」→ 音声で応答 → 要点を通知。 |

| Perplexity | Ask Perplexity 機能:テキスト(質問やプロンプト)を渡して、Perplexityの回答をテキストとして受け取る。共有シートから渡した選択テキストやURLも下敷きにできます。 使用例 Webページ要約 共有シート → ショートカット起動 Ask Perplexity(「本文を日本語で200字要約+箇条書き3点」) Obsidian/メモに保存 → 通知 比較調査のたたき テキスト入力を求める(製品A/B) Ask Perplexity(「比較表列:価格/特徴/長所/短所/向く人」) Markdown整形 → クリップボードにコピー New Search 機能:通常の検索(クイック検索)を開き、回答+出典リンクを取得。スピード重視。 使用例 今日のニュース要点 New Search(「○○県内ニュース 要点を3つ」) 結果テキストを取得 → 読み上げ → メモ追記 用語の一次理解 New Search(「DirectStorageの仕組みを初心者向けに3段階で」) 結果をリマインダーに登録(復習用) New Pro Search 機能:プロ検索を開始。複数ステップの深掘り・長文回答・出典精査に向く(時間は通常検索より長め)。 使用例 購入検討の深掘り New Pro Search(「10万円台ノートPCのおすすめ3台、要件:16GB/1TB/軽量。根拠とレビュー出典つき」) 結果から表を生成 → Numbers保存 技術比較(論拠付き) New Pro Search(「QZSS L1Sの災害配信の最近の更新点と実装留意点。公式資料の出典URLを併記」) 出典リンクをメモに保存 → 後で精読 New Image Search 機能:画像検索を起動。クエリに応じて画像結果を取得(URL/サムネ情報など)。 使用例 ブログ用フリー素材の下調べ New Image Search(「抽象 背景 テクスチャ 無地トーン」) 取得URLを表(Markdown)に整形 → Obsidian保存 製品の外観比較 New Image Search(「8BitDo Ultimate 2 Wireless 画像」) URL一覧をSafariで一括オープン → 目視で選別 音声モードを開始 機能:Perplexityの音声会話を起動。ハンズフリーで質問→回答(読み上げ)。 使用例 移動中の情報収集 このアクション → 「今日の○○市のイベント教えて」 要点を通知+カレンダー候補に追記 英語ニュースの要約を聞く このアクション → 「英語ニュースを日本語で3点に要約」 結果をメモ レシピの型(コピペして中身だけ差し替え) 共有シート → Perplexity要約 → 保存 共有シートから本文/URL取得 Ask Perplexity(プロンプト例:「出典名を括弧で示しつつ、見出し・要約150字・箇条書き3点。日本語。」) ファイルを保存( /01_inbox/AI_summaries/ に日付ファイル名)通知 通常検索 or Pro検索 切り替え 変数 searchModeをQuick/Proにし、条件分岐で New Search / New Pro Search を呼び分け。使い分けの目安 Ask Perplexity:既に手元にあるテキスト/URL/画像を“加工・要約・説明”したい時。 New Search:速く広く一次把握。 New Pro Search:根拠つきで深掘りしたい時。 New Image Search:ビジュアル探索。 音声モード:手放し・ながら調べ。 |

| Gemini | Gemini と Live で会話 機能:GeminiのLive会話(音声対話)を起動。マイクで話してAIとやり取り。 使用例: 「出勤前のToDoを音声で相談」→ このアクション →(結果を)通知。 「今から英語で発音練習」→ このアクション → 録音を開始(別アクション)で自分の発話もログ化。 Gemini とファイルを共有する 機能:ショートカットで取得したファイル(PDF/Doc/テキストなど)をGeminiへ渡して解析・要約・質問。 使用例: ファイルを選択 → 2) このアクション → 3) テキストを取得(Geminiの出力)→ 4) メモに追加。 仕事の議事録PDFを渡して「要点・ToDo抽出」を自動保存。 Gemini と画像を共有する 機能:画像をGeminiに渡して要約・説明・OCR的な読み取り・アイデア出し。 使用例: 写真を撮る → このアクション → 「ホワイトボードの内容を要約・箇条書き化」→ リマインダーに追記。 レシピの写真から材料リストを抽出し、買い物リストに登録。 Gemini プロンプトを入力する 機能:テキストプロンプトをGeminiに送って応答を受け取る。最も汎用。 使用例: 選択したテキスト → このアクション(「3文に要約して」等のプロンプト)→ クリップボードにコピー。 Safariのページ本文を取得 → 「SEO見出し案を10個」→ Obsidianにファイル保存。 Gemini マイクを開く 機能:Geminiの音声入力を開く(クイックに話しかけたい時向け)。 使用例: Appスイッチャーからワンタップで「今日の予定を要約して」と話す→ カレンダーと突き合わせ(別アクション)→ 通知。 OpenCameraWithGeminiShortTitle(ユーザーの環境固有) 機能:カメラを開いて即Gemini連携するトリガー(Gemini側が提供/生成したカスタムのショートタイトルの可能性)。 使用例: ワンタップでカメラ起動 → 撮った写真を即「Gemini と画像を共有」へ渡す → 説明テキストを読み上げ。 |

| Adobe Acrobat | AIアシスタントでPDFを要約 機能:AcrobatのAIアシスタントにPDFを渡して要約/質問。出力はテキストで取得可能。 使用例: ファイルを選択(PDF)→ このアクション(「見出し+要点+アクション項目を抽出」)→ メール下書きに挿入。 定期レポートPDFを毎週要約→ Obsidianの所定フォルダに自動保存。 |

(補足)「共有シート」という言葉がたびたび回答に含まれているが説明が長くなるので下記の記事にまとめた。

Perplexity Proにも同じ質問をした。

Perplexity Pro の回答

上記の回答でも示されているが、ショートカットを使用することで、ほぼノーコードで、一連の処理を順次実行することができる。

(追記)複数のAIを組み合わせて使うことについて下記のように記載したが、ショートカットでは困難であることが分かった。iPhoneのショートカットは、複数種類のAIのアクションを備えているので、ChatGPTとPerplexity Pro に同じ質問を行い、それらの回答を統合する、それらの回答の共通点・相違点を回答させるといった使い方もできそうである。

ChatGPTとPerplexity Proの両AIが薦める地元の店を回答させるとか。

また、小さな処理単位のアクションを組み合わせるので、処理の追加・削除が容易に行え、出先でも状況に応じて構成を容易に組み替えることができ、好みに応じて付加価値を調整することができる。ショートカットも、ある意味、AIエージェントと言えるのではないか。

どのAIにもカメラ機能はあるが、Geminiにはファイル添付のアクションが設けられている。

次に詳細設定画面があるアクションをいくつか紹介する。

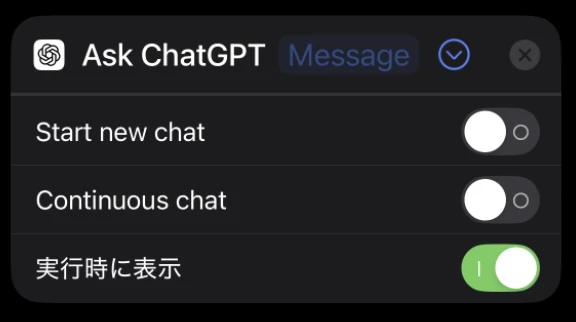

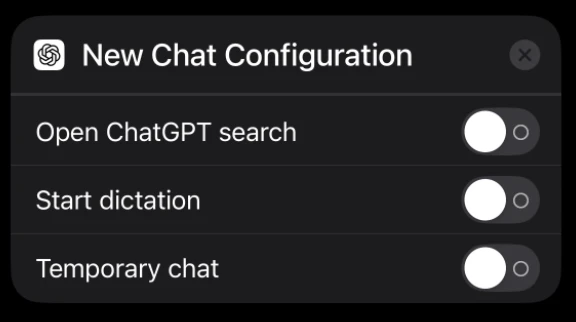

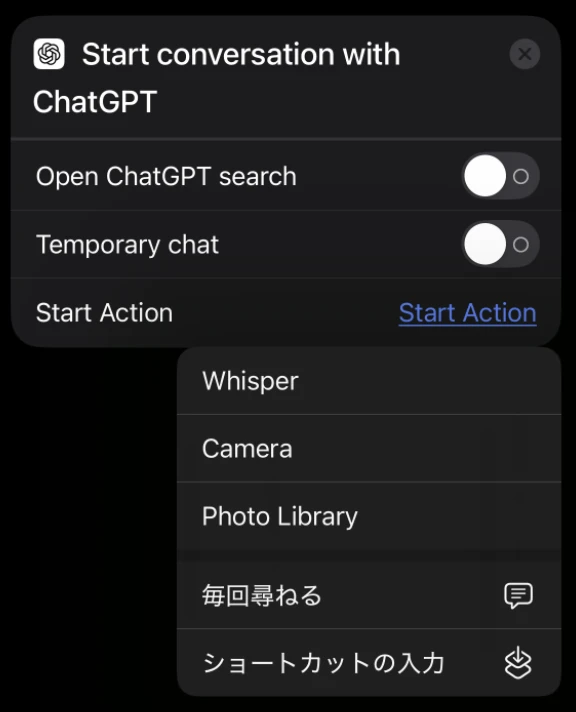

上図の詳細設定画面について設問した。

| 質問 | GPT 5 Thinking の回答 |

|---|---|

| continuous chatはどのように使いますか | 何をする? 同じショートカット実行中に、やり取り(追質問)を続けられるモードです。最初の質問→返答のあと、ショートカットの画面上でそのまま「つづけて質問」を受け付け、同一スレッドの文脈が維持されます。 典型的な使い方 1回で終わらないリサーチや要約精度の微調整を、ショートカットの中で連投したいとき。 「下書きを出力 → “語尾を丁寧に”と追指示 → “見出しを3つに”と再指示」のように、段階的に整えるフロー。 ポイント オフ:1発質問→1発回答で終了(出力は次のアクションに渡せます)。 オン:会話が続くUIになり、完了を押すまでフォローアップ可能。 会話の文脈はその実行中のみ保持(実行を終えるとリセット)。 |

| start actionはどのように使いますか | 何をする? ChatGPTアプリを開くときに、最初に起動する入力モードを指定します。 選べる例(画像の例) Whisper:音声→テキスト入力を即開始(ハンズフリーで話しかけたいとき最適)。 Camera:カメラを起動して、その場で撮った写真を添付して質問開始。 Photo Library:アルバムから既存の画像を選んで質問開始。 毎回尋ねる:実行時にどれにするか選択。 ショートカットの入力:前段のアクションから渡された入力(テキスト/画像)をそのまま使う。 典型的な使い方 「写真→その場で解析」フロー:Start Action を Camera に固定。 「音声メモ→要約」フロー:Start Action を Whisper に固定。 前段で画像やテキストを加工してから渡す:Start Action を ショートカットの入力 に。 ポイント これはChatGPTアプリをどう開くかの初期動作指定で、Ask系アクションの会話APIそのものの挙動とは別です。 「Open ChatGPT search」や「Temporary chat」と組み合わせて、検索UI優先で開く/一時チャットで開くなどの起動プリセットが作れます。 |

| start dictationはどのように使いますか | 何をする? 新規チャットを開いた瞬間に、iOSの音声入力(キーボードの“マイク”)を自動で開始します。画面遷移→マイク待ち受けまでをワンタップ短縮。 典型的な使い方 走りながらや台所で、手を使わずに「新規→話す→送信」までサクっとやりたい。 「メモ→要約→下書きをメールへ」など、声で始める固定フローの入口。 前提と注意 iOSの“音声入力”が有効であること(設定>一般>キーボード>音声入力)。 ChatGPTアプリ側でマイク権限が許可されていること。 これは“新規チャットを開く系のアクション”に付くトグル。既存スレッドでの追記ではなく、新規開始のときに効きます。 |

| これらの質問に対するGPT 5 Thinkingの コメント | 使い分けのコツ(ショート構成例) その場で写真→解析→追質問 Start conversation with ChatGPT - Start Action:Camera - Temporary chat:オン(痕跡を残さない用途なら) Ask ChatGPT(continuous chat:オン) → 画像解析の返答を受け、同スレッドで追加質問。 - Start dictation:オン(開いたらすぐ話せる) Ask ChatGPT(“要約して”のプロンプト、continuous chat:オン) → 返答後に「見出し3案にして」と続ける。 一発処理で次のアクションへ渡す(非対話) Ask ChatGPT(continuous chat:オフ) テキスト処理→ファイル保存/コピーなどへ直結 → バッチ的に1往復で確定出力したいときに最適。 |

continuous chatは、会話の文脈はその実行中のみ保持という制限はあるが、有用な、多くの人が待ち望んでいた機能ではないかと思う。以前、AlexaからChatGPTを呼び出して会話するというスキルに興味を持っていたことがあるが、セッションが続かず、前の会話を受けて、さらに絞り込みの質問を行うというようなことができないことが分かりがっかりしたことがある。

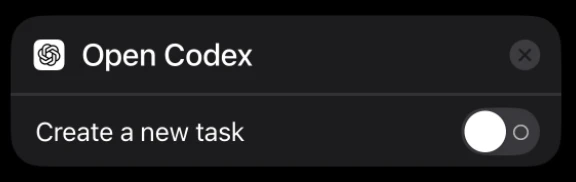

(追記) OpenAI関連のアクションに「Open Codex」というものがあったが、どのようなシーンで、このアクションを使うのかよく分からなかったので、さらに質問した。

iPhoneのChatGPT関連のショートカットに、codexというアクション(new taskという設定の切り替えもあり)がありますが、これは、例えば、どのような利用形態がありますか

GPT 5 Thinking の回答

良い質問です。結論だけ先に:iPhoneのショートカットにある「Codex」アクションは、“Codexのタスク(Cloud Task)を作る/続ける”ためのトリガーとして使えます。ショートカットからリポジトリURLや指示文(プロンプト)を渡して、新規タスク(New task)を作成したり、既存タスクに追記(続行)したりする使い方が中心です。これにより、外出先で用件だけ投げる → 後でMacのIDEやCodex CLIで仕上げるという分業がやりやすくなります。

Codex側の“クラウドタスク”機能は最近のアップデートで公式に案内されています。(OpenAI)

以下、代表的な利用形態とレシピ例です。

代表的な利用形態(ユースケース)

- 「思いついた時に新規タスク化」

Siri/アクションボタン/ホーム画面からショートカットを起動 → 「Codex(New task)」に要件の一文と対象リポジトリURLを渡す → Codexがクラウド上でタスクを起票(例:“repo X の設定でLintとTestを分離、CI を修正してPR案を作って”)。デスクに戻ってからIDEやCodex CLIで詳細を詰める。(OpenAI) - GitHubアプリやSafariの“共有シート”からワンタップ送信

GitHubのIssue/PR/ファイルページを共有シート→ショートカット→Codex(New task)。URLメタ情報とあなたの指示をまとめて渡すので、Codex側で対象範囲の把握→作業計画の下書きまで走る。(OpenAI) - バグ報告→修正の“下ごしらえ自動化”

スクショやログのテキストを添えて「再現手順→期待結果→回避策」をショートカットで整形し、Codexへ新規タスク提出。後でIDEから修正パッチやPR本文の骨子を受け取る流れに。(OpenAI) - RAG/ドキュメント整備の入口

“READMEを整理”“変更点の要約”など軽作業をタスク化だけ先に。Codexのクラウドタスクは後からエディタで開き直せるため、モバイル→デスクトップ間のコンテキスト切り替えが楽。(OpenAI) - 家の外で“CI落ちの一次対応”指示

CIの失敗通知を受けたら、失敗ログURLをショートカット→Codex(継続/追記)に送り、暫定の切り戻し案や原因仮説の列挙を依頼。帰宅後に詳細対応。(OpenAI) - Apple Intelligenceの“Use Model”との併用

iOS 26のショートカットにはUse ModelなどAIアクションが増えたので、前段で整形・要約→後段でCodexへタスク化という2段構成にすると入力が安定します。(Matthew Cassinelli)

実用ショートカットのレシピ例(3本)

A. 「アクションボタン長押し→新規Codexタスク」

- 入力:音声またはテキスト(やりたい事)、クリップボードのURL(あれば)

- 流れ:

1) 「テキストを取得」→空なら音声入力

2) 「クリップボードを取得」→URLならそのまま保持

3) (任意)Use Modelで“要件を箇条書き化”

4) Codex(New task=オン):タイトル・説明・URLを渡す - 効果:移動中に“要件だけ確定”できる。(OpenAI)

B. 「GitHub共有シート→PRレビュー依頼をタスク化」

- 入力:共有シートのURL(PR/差分)、コメント(任意)

- 流れ:

1) 共有インプットからURL抽出

2) “レビュー観点テンプレ(安全性・パフォ・可読性)”を付与

3) Codex(New task=オン)に送信(“主要懸念の要約+修正提案+レビューコメント案を作って”) - 効果:レビュー下ごしらえをクラウドに投げ、後でIDEで微調整。(OpenAI)

C. 「CI失敗通知→Codexに原因仮説・修正方針を下書き」

- 入力:失敗したジョブURL、ログの一部

- 流れ:

1) URL+ログを1つのテキストに整形

2) Codex(New task=オフ)=既存“CI障害対応”タスクに追記

3) “再現手順・影響範囲・暫定回避策”を出力するよう依頼 - 効果:モバイルで一次分析を依頼→帰席後に修正。(OpenAI)

使う前のチェックポイント

- Codex側の準備:OpenAIアカウントでCodexを有効化。GitHub連携や必要な権限付与(リポジトリアクセスなど)を済ませる。(OpenAI)

- “Cloud Task”の前提:Codexの“クラウドタスク”はエディタ連携やCLIと往復できる設計。iPhoneで起票→Macで仕上げが前提だと快適です。(OpenAI)

- iOS側の注意:バックグラウンド実行やネットワーク状況により長時間の処理は不向き。タスク化(依頼の出し分け)に特化させると安定。(Tom’s Guide)

必要なら、あなたのワークフロー(GitHub・Obsidian・ブログ・GNSS開発など)に合わせた“ショートカット雛形”(入力項目、プロンプト定型、Codexタスクのフィールド割り当て)をこちらで作成します。どのアプリから何を渡したいかだけ教えてください。