下記の記事で、Edge Impulseのサイトの主要画面について紹介したが、無料アカウントを作成し、ログインしたので、本記事ではログイン後に表示される画面について説明する。画面の各メニューの説明は、ChatGPT Atlasにお願いした。Atlasが画面を見ているので、画面について説明する必要がなく、質問内容だけ伝えれば良いので楽。

調べてみると、Arduino UNO Qを、Edge Impulseに接続することができることが分かったので、その状態でどのようなことができるかについても調べた。

(注)本記事の内容は正確性を保証するものではない。

(2025年12月30日 追記)YouTube動画を追加しました。 https://youtu.be/TnvEXAw7Nu4

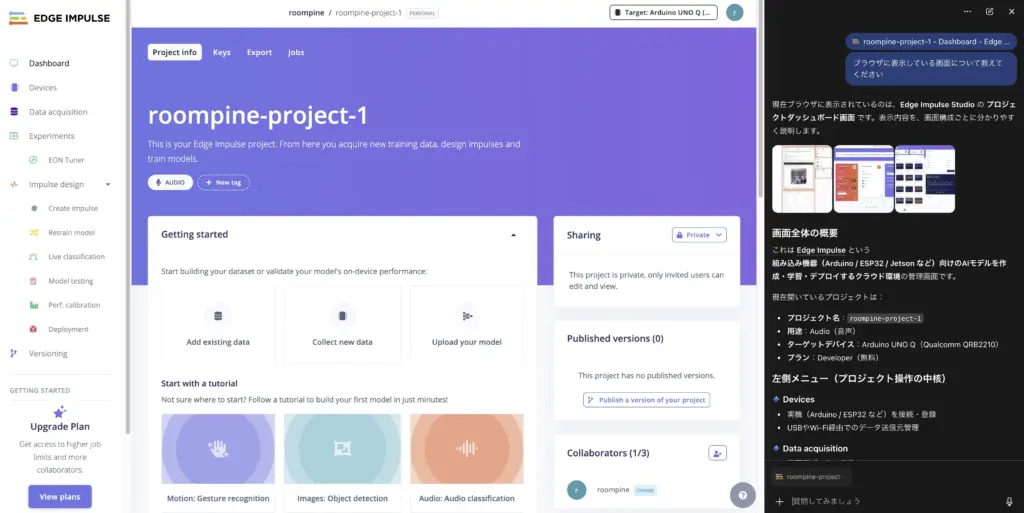

名前を登録しログインすると、Dashboard画面が表示され、左側のペインには「左側メニュー」が表示される。

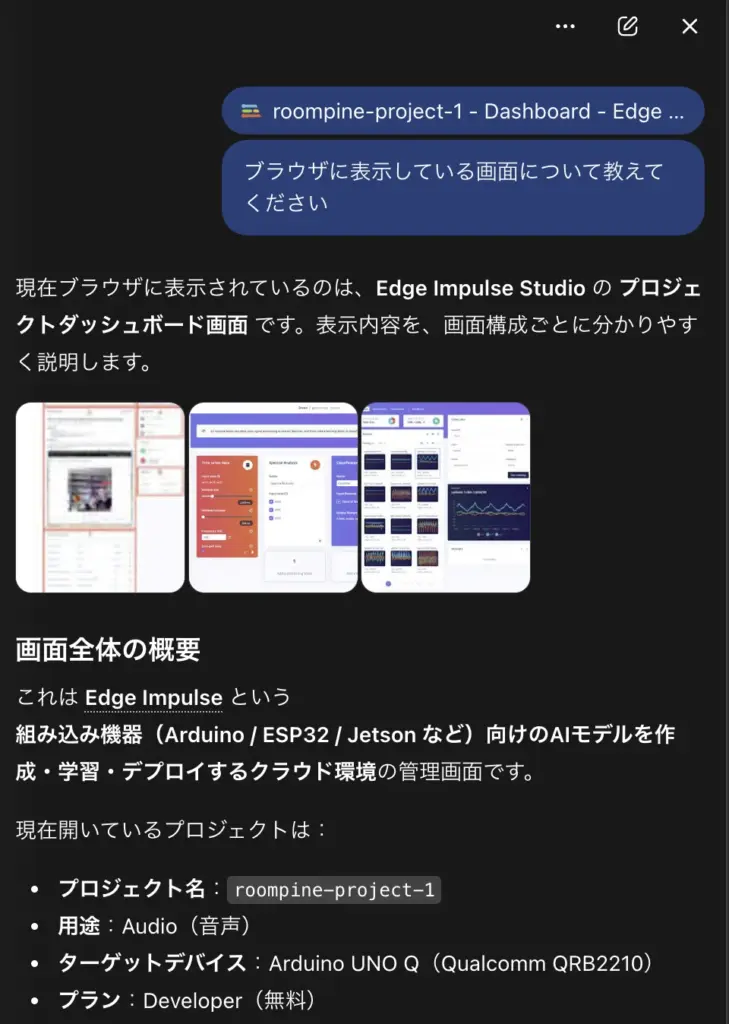

画面の右側にAtlasのチャット画面を開き、「ブラウザに表示している画面について教えてください」と指示した。

Dashboard画面

Dashboard画面

左側メニュー(1)

左側メニュー(2)

チャット画面

チャット画面に表示されたAtlasの回答

現在ブラウザに表示されているのは、Edge Impulse Studio の プロジェクトダッシュボード画面 です。

表示内容を、画面構成ごとに分かりやすく説明します。

画面全体の概要

これは Edge Impulse という組み込み機器(Arduino / ESP32 / Jetson など)向けのAIモデルを作成・学習・デプロイするクラウド環境の管理画面です。

現在開いているプロジェクトは:

- プロジェクト名:

roompine-project-1 - 用途:Audio(音声)

- ターゲットデバイス:Arduino UNO Q(Qualcomm QRB2210)

- プラン:Developer(無料)

左側メニュー(プロジェクト操作の中核)

🔹 Devices

- 実機(Arduino / ESP32 など)を接続・登録

- USBやWi-Fi経由でのデータ送信元管理

🔹 Data acquisition

- 学習用データの収集

- マイク入力(音声)

- センサー値

- 既存データのアップロード(WAV / CSV など)

🔹 Impulse design / Experiments

- Impulse(前処理+MLモデル構成)の設計

- DSP(例:MFCC)

- ニューラルネットワーク

- 学習・再学習の実行

🔹 Live classification

- 実機を使ったリアルタイム推論

- マイク入力 → 即時分類結果を表示

🔹 Model testing

- テストデータによる精度評価

- 混同行列・精度・F1スコアなど

🔹 Deployment

- 学習済みモデルの書き出し

- Arduinoライブラリ

- C++ / TensorFlow Lite

- Linux / Edgeデバイス向け

中央エリア(Dashboard の内容)

✅ Getting started

初心者向けのスタートガイド:

- 既存データを追加

- 新規データを収集

- チュートリアルへのリンク(音声分類・画像認識など)

✅ Impulse #1

- 現在作成されている 最初のImpulse

- まだ学習やダウンロードは未実行の状態

✅ Performance settings

- GPU使用の有無

- 学習ジョブのメモリ制限

- 無料プランでは一部制限あり

右下・下部エリア

🔸 Project info

- Project ID

- ラベリング方式(1データ=1ラベル)

- 公開/非公開設定

🔸 Sharing / Collaborators

- プロジェクトの共有設定

- 共同編集者の追加(無料枠は人数制限あり)

まとめ(今この画面でできること)

この状態は 「AIプロジェクトの初期状態」 です。

次の一手としては:

- Data acquisition で音声データを集める

- Impulse design で MFCC+分類モデルを設定

- Train してモデルを学習

- Live classification で Arduino UNO Q 上で動作確認

という流れになります。

もしよければ、次に進みたい内容を教えてください。

- 🎤 音声データの集め方を詳しく

- 🤖 Arduino UNO Q との接続手順

- 🧠 Impulse(MFCCやモデル構成)のおすすめ設定

- 📝 ブログ記事向けの画面解説用まとめ

など、用途に合わせて詳しく説明できます。

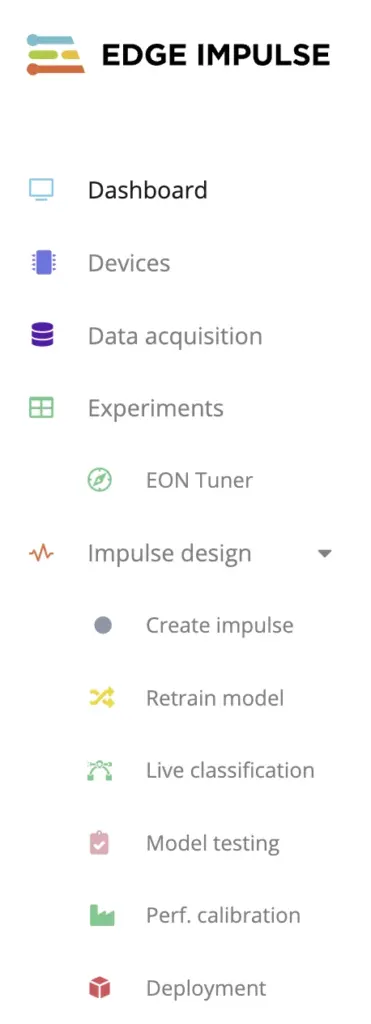

左側メニューで、隠れていたメニューを表示させました。

Deployment以降のメニューについて説明してください

左側メニュー(2)が隠れていたので、それを表示して隠れていたメニューについての説明を求めた。

チャット画面に表示されたAtlasの回答

了解しました。

左側メニューで Deployment より下に表示される項目 について、役割・使うタイミング・注意点の順で説明します。

Deployment(基準点のおさらい)

※ここから下が、今回の説明対象です。

- 学習済みモデルを 実機で使う形に書き出す ための画面

- Arduinoライブラリ / C++ / Linux / TFLite などを生成

- 「モデル完成後」に必ず通る工程

Versioning(バージョン管理)

何をするメニュー?

- プロジェクト全体のスナップショットを保存・公開する機能

- データ・Impulse構成・学習済みモデルを含めて1セットで管理

主な用途

- 「この時点のモデル」を後から再現したい

- 他人に 再現可能な状態で共有 したい

- ブログ・Qiita・GitHubで紹介する際のリンク作成

重要ポイント

- 公開すると 3-Clause BSD ライセンス でクローン可能

- 学習データそのものではなく「構成と結果」を共有

- 実験を進める前の 区切り地点で保存 するのがコツ

Project info 系メニュー

(上部に並ぶが、隠れて見落としやすい重要項目)

🔑 Keys

- デバイス登録用の APIキー

- Arduino / ESP32 / Linux デバイスが

- データ送信

- ライブ推論

を行うために使用

👉 実機接続時は必須

📦 Export

- プロジェクトやモデルの 外部持ち出し

- 研究・バックアップ・別環境移行向け

用途例:

- 企業内レビュー

- オフライン保存

- 別アカウントへの移行準備

🧾 Jobs

- 学習・最適化などの 実行履歴

- 失敗した学習ジョブのログ確認

ここで分かること:

- なぜ学習が失敗したか

- メモリ不足・時間超過・設定ミス

👉 トラブルシューティング時に非常に重要

Administrative / Danger 系(下部)

⚙ Performance settings

- GPU使用可否

- メモリ制限

- 無料プランでは一部制限あり

通常は 触らなくてもOK

☠ Danger zone

- データ全削除

- Train/Test split の再実行

- プロジェクト削除

👉 操作は慎重に

(特に Train/Test split は再現性に影響)

メニューの使い分けまとめ

| フェーズ | 主に使うメニュー |

|---|---|

| 開発中 | Data acquisition / Impulse / Train |

| 実機確認 | Live classification |

| 配布・実装 | Deployment |

| 保存・共有 | Versioning |

| 実機接続 | Keys |

| トラブル対応 | Jobs |

Arduino UNO Q を使う場合の実践的な流れ

今回の構成(Arduino UNO Q + Audio)だと:

- Deployment

→ Arduino Library を生成 - Keys

→ APIキーを Arduino スケッチに設定 - Versioning

→ 動いた時点をバージョン保存 - Jobs

→ 学習失敗時の原因確認

という使い方になります。

次に進むなら、どこを詳しく見ますか?

- 🔧 Deployment → Arduino Library の中身解説

- 🔑 Keys を Arduino スケッチにどう書くか

- 🧠 Versioning をブログで共有する方法

- 🧾 Jobs のログの読み方(失敗例つき)

用途に合わせて、かなり踏み込んだところまで説明できます。

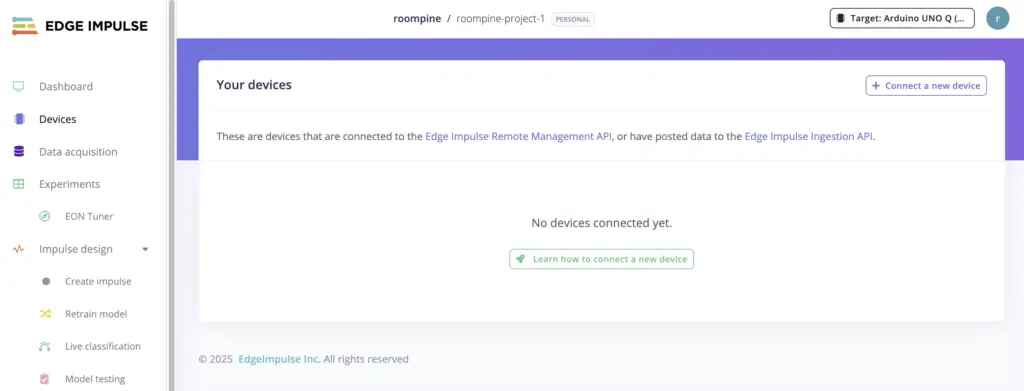

Devicesのページに切り替えました。

Arduino UNO Q とかのデバイスと接続する際に使用するページですか

左側メニュー(1)で、画面を「Devices」に変えて質問を続けた。

チャット画面に表示されたAtlasの回答

はい、その理解で 正しいです。

今表示している Devices ページは、Arduino UNO Q などの実機デバイスを Edge Impulse プロジェクトに接続・管理するためのページです。

Devices ページの役割(結論)

このページは、

- 🔌 デバイスを Edge Impulse に「登録・接続」する

- 📡 どの実機がデータ送信・推論に参加しているかを管理する

ための 実機連携専用ページです。

このページでできること

① デバイス接続の入口(Connect a new device)

ここから次のような接続方法に進みます。

- Arduino UNO Q / ESP32 / 他マイコン

- PC(Linux / macOS / Windows)

- スマートフォン(ブラウザ経由)

内部的には、

- Ingestion API(データ収集)

- Remote Management API(デバイス管理)

を使ってプロジェクトと紐づけています。

② 接続済みデバイスの一覧表示

画面中央の表:

| Device | ID | Type |

|---|---|---|

| (現在は No devices connected yet) |

ここに、

- Arduino UNO Q

- ESP32

- PC(data-forwarder)

などが 接続されると表示 されます。

👉 表示されていれば

「このデバイスは Edge Impulse と通信できている」

という状態です。

③ Live inference の管理

デバイスが接続されると:

- Live classification(リアルタイム推論)

- 実機からの推論結果表示

の対象デバイスとして使われます。

Arduino UNO Q との関係(重要)

Devices ページは「最初の関門」

Arduino UNO Q を使う場合、流れはこうなります。

- Devices

- Arduino UNO Q を Edge Impulse に接続

- 「認識されているか」を確認

- Data acquisition

- マイクなどのデータを送信

- Impulse / Train

- モデル作成・学習

- Live classification

- Arduino UNO Q 上でリアルタイム推論

- Deployment

- Arduino ライブラリとして書き出し

つまり Devices は実機連携の起点 です。

Devices ≠ Data acquisition(よくある混乱)

| ページ | 役割 |

|---|---|

| Devices | デバイスを「登録・接続」する |

| Data acquisition | 接続済みデバイスから「データを集める」 |

👉 Devices に出てこないと、Data acquisition では使えません

今の状態の意味

表示が:

No devices connected yet.

となっているので、

- まだ Arduino UNO Q は接続していない

- もしくは接続手順の途中

という段階です。

次にやる典型的な操作

Arduino UNO Q を使うなら、次はどちらかです。

- 🔧 Arduino UNO Q を USB 接続して認識させる手順

- 🧩 Edge Impulse CLI / data-forwarder を使う方法

- 🎤 マイク付きで音声データを送る最短ルート

どこから進めるか決めていただければ、

コマンド・注意点・つまずきやすいポイントまで含めて説明します。

Arduino UNO Q を Edge Impulse に接続すると、どのようなことができるのですか

チャット画面に表示されたAtlasの回答

Arduino UNO Q を Edge Impulse に接続すると、

「実機で AI を学習・評価・実装する一連のこと」 ができるようになります。

単なるモデル作成にとどまらず、UNO Q 上で“動くAI”を確認できるのが最大のポイントです。

まず結論(できることの全体像)

Edge Impulse × Arduino UNO Q を接続すると、次のことが可能になります。

- 実機(UNO Q)から センサーデータや音声を直接収集

- UNO Q を使って リアルタイム推論(Live classification)

- 学習済みモデルを UNO Q 用の Arduino ライブラリとして書き込み

- メモリ・速度・消費電力を 実機ベースで評価

- PC不要の スタンドアロンAIデバイス を作成

① 実機からデータを集められる(最重要)

何ができる?

- UNO Q に接続された

- マイク

- センサー

から 実際の環境データ を Edge Impulse に送信

なぜ重要?

- WAVファイルや疑似データではなく

👉 本番と同じ条件のデータで学習できる - 音声AIでは特に精度差が大きく出る

② UNO Q 上でリアルタイム推論(Live classification)

できること

- UNO Q のマイク入力 → 即座に推論

- 推論結果を Edge Impulse 画面で可視化

例:

- 「音A / 音B / 無音」

- 「異音あり / なし」

- 「キーワード検出」

👉 PC上のシミュレーションではなく、実機で確認できる

③ 学習済みモデルを UNO Q に書き込める(Deployment)

具体的に

- Edge Impulse が

UNO Q 向け Arduino ライブラリ を自動生成 - Arduino IDE で書き込み可能

結果

- ネット接続なし

- Edge Impulse なし

でも UNO Q 単体でAI推論が動作

④ 実機ベースで性能評価ができる

UNO Q を接続していると、次が分かります。

- 推論にかかる時間(ms)

- RAM / Flash 使用量

- モデルが重すぎないか

- 実運用で問題がないか

👉 「理論上動く」ではなく「実際に動く」かを確認

⑤ できる代表的な用途(UNO Q × Audio)

特に今回の構成(Audio)では:

- 🔊 音声分類(生活音・機械音)

- 🚨 異音検知

- 🎙 キーワード検出(簡易)

- 🏠 環境音モニタリング

などが現実的です。

ページごとの役割まとめ(UNO Q 接続後)

| ページ | UNO Q でできること |

|---|---|

| Devices | UNO Q を登録・接続 |

| Data acquisition | UNO Q から音声を収集 |

| Live classification | UNO Q 上でリアルタイム推論 |

| Model testing | 精度の数値評価 |

| Deployment | UNO Q 用ライブラリ生成 |

逆に「できないこと」も知っておくと安心

- クラウド推論(UNO Q はローカル推論)

- 高解像度画像処理(UNO Q は音声・軽量向け)

- 巨大モデルの実行

👉 小さく・速く・省電力なAI向け

まとめ(ひとことで)

Arduino UNO Q を Edge Impulse に接続すると、

「実際の環境音を使って学習し、UNO Q 単体でAI判断する装置」

を作れるようになります。

次はどこを詳しく見たいですか?

- 🔌 UNO Q を実際に接続する具体手順

- 🎤 音声データ収集の設定(マイク周り)

- 🤖 Live classification の見方

- 📦 Deployment で生成される Arduino コードの中身解説

UNO Q 特有の注意点も含めて、かなり実践的に説明できます。

Arduino UNO Q を Edge Impulse に接続するのと、Arduino UNO Q を App Labに接続するのとではどのような違いがありますか。データをPCに一旦ダウンロードする必要があるかとか、リアルタイムで状況を確認できるかとか、収集中のデータの良し悪しをリアルタイムで確認できるかとかですか

チャット画面に表示されたAtlasの回答

とても本質的な質問です。

結論から言うと、

Edge Impulse と App Lab は「目的」と「データの流れ」がまったく違う

という理解が一番しっくりきます。

ご質問の 「PCに一旦ダウンロードが必要か」「リアルタイム性」「データ品質の確認」 という観点で、整理して説明します。

前提整理(何と何を比べているか)

- Edge Impulse × Arduino UNO Q

- 👉 エッジAI開発プラットフォーム

- Arduino UNO Q × App Lab

- 👉 学習・可視化・試作向けのアプリ連携/UIツール

両者は「似たことができそう」に見えますが、

データの扱い方とゴールが根本的に違います。

① データの流れの違い(ここが一番重要)

Edge Impulse の場合

UNO Q →(リアルタイム送信)→ Edge Impulse Studio

→ そのまま学習・評価・推論に使用

- ✅ PCに一旦保存する必要なし

- ✅ 収集中のデータが そのまま学習用データになる

- ✅ 「今取っているデータ」が 即AI開発に直結

App Lab の場合

UNO Q →(シリアル等)→ PC / ブラウザ

→ 表示・確認

→(必要なら)CSV等で保存

→(別途)学習環境へ

- ⚠ 基本は「人が見るためのデータ」

- ⚠ 学習用に使うなら 後処理が必要

- ⚠ データ取得とAI学習は 分離されている

② リアルタイム性の違い

| 観点 | Edge Impulse | App Lab |

|---|---|---|

| センサー値の即時表示 | ◯ | ◎ |

| AI推論結果の即時表示 | ◎(Live classification) | ✕ |

| データと推論の一体表示 | ◎ | ✕ |

Edge Impulse

- 入力 → 前処理 → 推論 → 結果

- この一連を UNO Q 実機ベースでリアルタイム確認

👉

「この音、ちゃんと“異音”として判定されているか?」

をその場で確認できる

App Lab

- センサー値・状態表示は得意

- ただし AI推論という概念は基本なし

👉

「値は取れているか?」

「配線・センサーは正しいか?」

の確認向き

③ 収集中データの「良し悪し」をリアルタイムで確認できるか

Edge Impulse:できる(しかもAI目線)

- 波形

- 特徴量(例:音声のMFCC)

- クラスごとの分布

- 推論結果の信頼度

👉

「このデータは学習に向いていない」

という判断が 収集中に可能

App Lab:人間の感覚頼り

- グラフ

- 数値

- 状態表示

👉

「ノイズが多そう」

「値が飛んでいる」

は分かるが、

❌ AI的に良いかどうかは分からない

④ 「AI開発」という観点での決定的な違い

Edge Impulse

- データ収集

- 前処理

- 学習

- 実機推論

- 性能評価

👉 全部つながっている

App Lab

- データ可視化

- UI操作

- 学習用途は想定外

👉 AI開発は別途必要

⑤ 使い分けの指針(UNO Qユーザー目線)

App Lab が向いている場面

- センサーや配線の初期確認

- 値が取れているかの確認

- 人に見せるデモUI

- 学習しない制御系

Edge Impulse が向いている場面

- 音・振動・センサーを AIで判別したい

- データの良否を その場で判断したい

- 最終的に UNO Q単体でAI判断させたい

⑥ 一言でまとめると

- App Lab

- 👉 「人が見る・操作する」

- Edge Impulse

- 👉 「AIが学ぶ・判断する」

実践的なおすすめ構成(かなり王道)

- App Lab

- センサー・配線・値の安定性を確認

- Edge Impulse

- 本番データ収集

- AI学習

- UNO Qでリアルタイム推論

👉 併用がベスト です。

次に進むなら、かなり面白いところです。

- 🎤 「この音は学習に向いていない」例を Edge Impulse でどう見抜くか

- 🔍 App Lab → Edge Impulse に移行する判断ポイント

- 🧠 UNO Q で“学習に失敗しやすいデータ”の典型例

どれも、実機を触る人ほどハマる話なので、続けて深掘りできます。

開発の手順(順序)としては、まず、Arduino UNO Q を App Lab に接続して、センサー等の接続状態の確認、Pythonコードやスケッチの編集、デバッグまで済ませ、その後、Edge Impulseに接続してデータ収集を行うということでいいですか

チャット画面に表示されたAtlasの回答

はい、その理解で とても良いです。

むしろ 現実的で失敗しにくい“王道の開発手順” です 👍

順序としても合理的なので、少し補足しながら整理します。

結論(先に要点)

おすすめの開発順序は次のとおりです。

① App Lab → ② Edge Impulse

(最後に ③ 両者を切り替え/統合)

この流れで問題ありません。

なぜこの順序が正しいのか(理由)

App Lab と Edge Impulse は「得意分野」が違うためです。

- App Lab

- 👉 低レイヤ寄り(ハード・コード・デバッグ)

- Edge Impulse

- 👉 AI寄り(データ品質・学習・推論)

いきなり Edge Impulse から入ると、

「配線ミスなのか?データが悪いのか?モデルが悪いのか?」

が分からなくなりがちです。

推奨される開発ステップ(詳細)

🟦 STEP 1:Arduino UNO Q × App Lab(基礎固め)

ここでやることは AI以前の“土台作り” です。

目的

- センサーが正しく動いているか

- コードが安定して動くか

- 想定どおりの値が取れるか

具体的作業

- Arduino UNO Q を App Lab に接続

- センサー配線の確認

- 値のレンジ・ノイズ確認

- Python / スケッチ編集

- デバッグ(例外・フリーズ・再起動など)

この段階で確認できること

- ✅ 値は取れているか

- ✅ 周期は安定しているか

- ✅ ノイズは許容範囲か

- ✅ 長時間動かしても落ちないか

👉 ここが不安定だと、AI以前に失敗します

🟦 STEP 2:Arduino UNO Q × Edge Impulse(AI用データ収集)

基礎が固まったら、ここで初めて AI視点 に移ります。

目的

- 「学習に使えるデータか?」を判断

- データを そのまま学習に使う

具体的作業

- UNO Q を Edge Impulse に接続

- Data acquisition でデータ収集

- 波形・特徴量・ラベルの確認

- Live classification で即時推論確認

この段階で分かること

- ✅ データにクラス差があるか

- ✅ ノイズが学習を邪魔していないか

- ✅ ラベル設計が正しいか

- ✅ 実機で推論できそうか

👉 App Lab では分からない「AI的な良し悪し」が見える

🟦 STEP 3:切り替え or 併用(実運用)

実際の開発では、こうなります。

- 普段のデバッグ

→ App Lab - データ追加・モデル改善

→ Edge Impulse

実務的な運用例

- 新しいセンサー追加

→ App Lab で確認 - 動作OK

→ Edge Impulse でデータ追加 - 精度悪化

→ Edge Impulse で原因分析 - 変な値が出る

→ App Lab に戻る

👉 往復するのが普通 です。

ご質問の観点で整理(チェック表)

| 観点 | App Lab | Edge Impulse |

|---|---|---|

| PCに一旦DLが必要 | ◯(必要なことが多い) | ✕(不要) |

| リアルタイム確認 | ◎ | ◎ |

| データ品質のAI評価 | ✕ | ◎ |

| 学習に直結 | ✕ | ◎ |

| デバッグ向き | ◎ | △ |

まとめ(ひとことで)

App Lab は「壊れていないかを見る場所」

Edge Impulse は「学べるかを見る場所」

なので、

App Lab → Edge Impulse

という順序は 理想的 です。

次に進むなら、かなり実践的な話ができます。

- 🔍 「App Lab ではOKなのに、Edge Impulseではダメなデータ」の具体例

- 🎤 音声データで“学習に向かないパターン”の見抜き方

- 🔁 App Lab ↔ Edge Impulse を切り替えるときの注意点

- 🧠 UNO Q で AI 学習が失敗しやすい典型ケース

どれも「実際にやる人ほどハマる」ポイントなので、続けて深掘りしましょうか。

新しく収集するデータの評価ではなく、App Labのサンプルアプリにもともと収録されているサンプルデータの評価をEdge Impulseでできますか

チャット画面に表示されたAtlasの回答

はい、できます。

しかも 新しくデータを取り直さなくても、

App Lab に最初から入っているサンプルデータを Edge Impulse で評価・学習に使うことは十分に現実的です。

結論(先に要点)

App Lab 付属のサンプルデータ → Edge Impulse に取り込み → 評価・学習

という流れは 公式想定どおり可能 です。

やることはシンプルで、

「サンプルデータをファイルとして取り出せるか」

「Edge Impulse が読める形式か」

この2点を満たせばOKです。

何ができるのか(範囲の整理)

- App Lab のサンプルアプリに含まれる

- センサーデータ

- 音声データ

- これらを 学習データとして評価

- モデルを作って

- 精度評価

- 特徴量の分離状況確認

- 推論テスト

👉 「このサンプル、AI的に意味あるの?」を検証できる

具体的な方法(現実的な手順)

STEP 1:App Lab のサンプルデータを取り出す

App Lab 側で、次のどれかができればOKです。

- CSV として保存

- WAV として保存

- JSON / Parquet などでエクスポート

※

「サンプルアプリ内部でしか参照できない」場合は、

一度 Python / スケッチで書き出すのが現実解です。

STEP 2:Edge Impulse にアップロード

Edge Impulse Studio の

- Data acquisition

→ Upload data

から、取り出したファイルをそのままアップロードします。

対応形式(代表例)

- CSV(センサー)

- WAV(音声)

- JSON / Parquet

👉 UNO Q を接続していなくても可能

STEP 3:学習・評価

アップロード後は通常の Edge Impulse と同じです。

- 特徴量(例:音声なら MFCC)

- クラス分布

- モデル精度

- 混同行列

などを確認できます。

重要な注意点(ここが落とし穴)

① サンプルデータは「きれいすぎる」ことが多い

App Lab のサンプルは:

- ノイズが少ない

- 条件が揃っている

- 実験用に作られている

👉

高精度が出ても「実環境で通用する」とは限らない

② ラベル設計が AI 向きでない場合がある

- 人が見て分かりやすいラベル

- AI的には境界が曖昧

というケースはよくあります。

👉

Edge Impulse で評価すると

「このラベル分けは無理がある」

と分かることも多いです。

③ 時系列・サンプリング間隔に注意

- サンプル間隔が不均一

- 欠損値がある

と、学習で失敗しやすくなります。

それでも「やる価値」は大きい理由

- センサーや音の “AI的な分離可能性” が分かる

- 本格収集に進む前の 判断材料 になる

- 「このテーマ、そもそもAI向き?」を早期に見極められる

👉

時間を無駄にしないための検証として非常に有効です。

位置づけを一言で

- App Lab のサンプル評価

- 👉 概念検証(PoC)

- 実機データ収集

- 👉 本番用

まとめ

- ✅ App Lab 付属のサンプルデータは Edge Impulse で評価可能

- ✅ UNO Q を接続する必要は 必ずしもない

- ⚠ 結果は「参考値」として扱うのが正解

次に進むなら、かなり実務的な話ができます。

- 📊 「Edge Impulse で見て、これは使えないと判断する指標」

- 🔍 サンプルデータ → 実データで精度が落ちる典型パターン

- 🧠 App Lab サンプルを“AI向き”に加工する方法

どれを深掘りしますか?

サンプルデータが使えるか使えないかだけでなく、どのように変えればいいか、どのようなデータを追加・削除すればいいかなどのアドバイスができますか

チャット画面に表示されたAtlasの回答

はい、できます。

Edge Impulse で「使える/使えない」を見るだけでなく、どう直すと良くなるか(追加・削除・取り方・ラベルの切り方)まで、かなり具体的に方針を出せます。

ただし前提として、どんなデータか(音声か、加速度など時系列か、画像か)で“効く処方箋”が変わります。

ここではまず、App Labのサンプルで多い 時系列センサー と 音声 を想定して、共通で使える実務的なチェックと改善案をまとめます。

1) Edge Impulseで「何を見て」改善方針を決めるか

A. 特徴量(Feature Explorer / 特徴量グラフ)

- クラスごとに“固まり”が分かれているか

- 重なっているなら →

データ追加(条件の追加) か ラベル設計の変更 が必要

B. 混同行列(Model testing)

- 間違いが 特定の組み合わせ に集中しているか

- 例:AとBがよく混ざる → A/Bの定義が曖昧 or センサーだけでは区別困難

C. 失敗サンプル(誤分類のサンプル)

- 失敗したデータに共通点があるか

- ノイズ

- 開始/終了の切り出しがズレ

- 無音・静止・待機が混入

- ラベルが誤っている

この3つを見るだけで、次の打ち手が決まることが多いです。

2) 追加・削除のアドバイスの典型パターン

「追加」した方がいいデータ(精度を上げる方向)

境界条件を足します。ここが一番効きます。

- 個体差:違う人、違う持ち方、違う設置場所

- 環境差:騒音あり/なし、床材、室温、反響など

- 強弱差:弱い動作/強い動作、遠い/近い

- 時間差:短い/長い、途中で止める、揺らぎ

- デバイス差:別のUNO Q、別センサー、別個体

👉 サンプルデータはだいたい「綺麗に取りすぎ」なので、現実のバラつきを足すほど強くなります。

「削除」した方がいいデータ(学習を壊す方向)

- ラベルが怪しい(人間でも迷う)

- 切り出しがズレている(開始前/終了後が長い)

- まったく別の現象が混ざっている(別クラスの動作が入っている)

- クリッピング/飽和(音割れ、加速度の上限張り付き)

- 無意味な“待機”が大量に入っている(静止/無音ばかり)

👉 「データ量が多いほど良い」は半分ウソで、悪いデータが混ざると一気に弱くなります。

3) ラベル設計を変えるアドバイス(効くことが多い)

よくある失敗は「人の言葉の分類」でAIを苦しめることです。

例:AとBが混ざる場合の処方箋

- A/Bを統合して1クラスにする(現実的)

- 逆に Aを2分割(A1/A2)して境界を明確化

- “その他/ノイズ/不明” クラスを追加して逃がす

(ただし入れすぎ注意)

4) 「切り出し(ウィンドウ)」の直し方(時系列・音声で超重要)

Edge Impulse は基本的に、データを一定長の窓(window)で見ます。

ここが合ってないと、どんなにデータを増やしても伸びません。

症状 → 対処

- 判定が不安定(同じ動作で結果が揺れる)

- → window を長くする / overlap を増やす

- 反応が遅い

- → window を短くする / overlap を調整

- 開始/終了に弱い

- → “イベント中心”で切り出す(開始前後を含めすぎない)

5) センサー追加・特徴量変更のアドバイスもできる

混ざり方によっては、データ以前に 情報が足りない ことがあります。

- 加速度だけで無理 → ジャイロを追加

- 音だけで無理 → 複数マイク位置 / 追加の振動センサー

- 環境ノイズが強い → ノイズ専用データを追加、特徴量を見直す

6) 進め方(最短ルート)

- サンプルデータをEdge Impulseに入れる

- まずモデルを1回作る(軽くてOK)

- 混同行列と誤分類サンプルを見る

- 「追加すべき境界条件」「削除すべき悪データ」「ラベル再設計」を決める

- その方針でデータを増やす

この流れで、かなり具体的な“次の一手”を出せます。

次に必要な情報(ここだけ分かれば、かなり具体化できます)

質問はしません。代わりに選択肢を出すので、当てはまるものを教えてください。

- ① データ種別:音声 / 時系列センサー / 画像

- ② 目的:分類(何かを当てる)/ 異常検知(いつもと違う)

- ③ クラス数:例:3クラス(A/B/C) みたいな感じ

これが分かると、

「このサンプルなら 何を削って、何を足して、ラベルをどう切るか」を、かなり踏み込んで提案できます。

Arduino UNO QなどのデバイスをEdge Impulseに接続することによって、AI推論の状況をEdge Impulseで確認できるところがすばらしい。データをどのように改善すれば良いかは、Edge Impulseから回答を得るというのではなく、その評価をAIに渡して回答を得るということになりそうだが、Atlasであれば評価画面を見てもらってアドバイスをもらうことができるかもしれない。