最近、Geminiが、Apple Intelligenceの基盤として使われるというニュースが流れ話題になっているが、具体的に、SiriやApple Intelligenceがどのように変わるのかのヒント・手がかりを、ChatGPT 5.2 Thinkingで調査した。

現状では、明確になっていないところも多いので参考情報として紹介する。

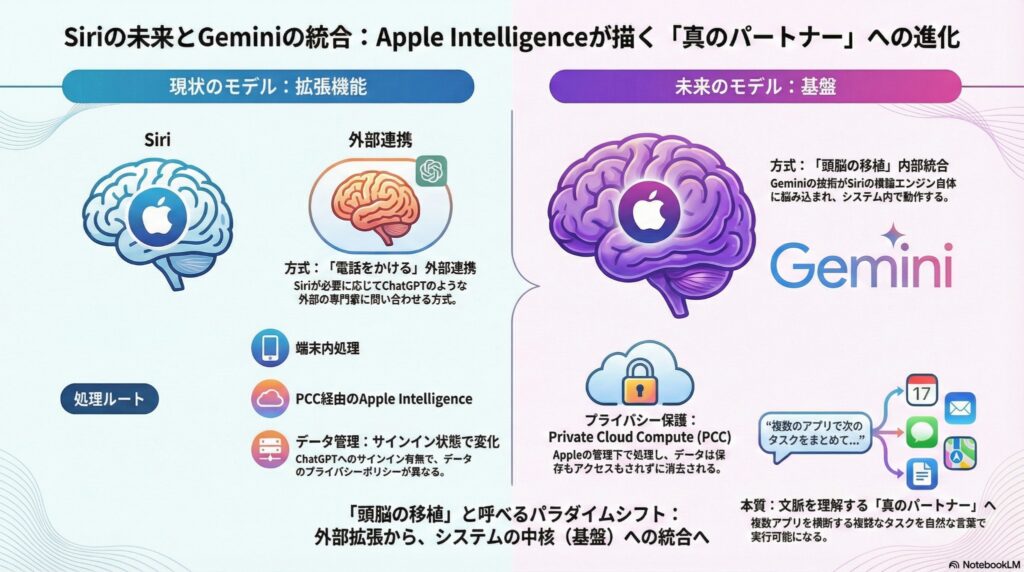

本記事の後半で、現在のSiriがどのように変わる可能性があるかについての調査結果を紹介するが、まずは、現在のSiriとChatGPTとの関係を調べ、SiriとGeminiとの関係もその関係と同様のものになるのかという切り口で、SiriとGeminiとの関係を調べることにした。

(注)本記事の内容は正確性を保証するものではない。

(2026年1月20日 追記)YouTube動画を追加しました。 https://youtu.be/buiz0STIcSk

(2026年1月21日 追記)下記YouTube動画で使用したスライドを本記事に追加しました。

(2026年1月24日 追記)YouTube動画を追加しました。 https://youtu.be/buiz0STIcSk

(Added on January 24, 2026) I have added an English version of the YouTube video: https://youtu.be/xIr0HbETLg8

現状のSiriとChatGPTとの関係

Siriに質問すると、ChatGPTが回答することがあります。この仕組みについて詳しく教えてください

ChatGPT 5.2 Thinkingの回答

了解です。まず「SiriからChatGPTに渡る経路」と「データがどこまで送られるか」を中心に、Apple公式情報に当たりながら、典型フローと設定手順・注意点まで整理します。

いま集めたApple公式(設定・プライバシー)とOpenAI公式の記載を突き合わせて、Siri→ChatGPTへ切り替わる条件、送信される情報、確認ダイアログの意味を整理して説明します。

Siriで質問したのに、途中から ChatGPTっぽい回答(長文・構成が整った説明、文章作成、画像/書類の要約など)が返ってくるのは、iOS/iPadOS/macOSの Apple Intelligence(インテリジェンス) が、必要に応じて 「ChatGPT拡張(Extension)」 を呼び出しているためです。 (Apple)

1) 何が起きている?(全体像)

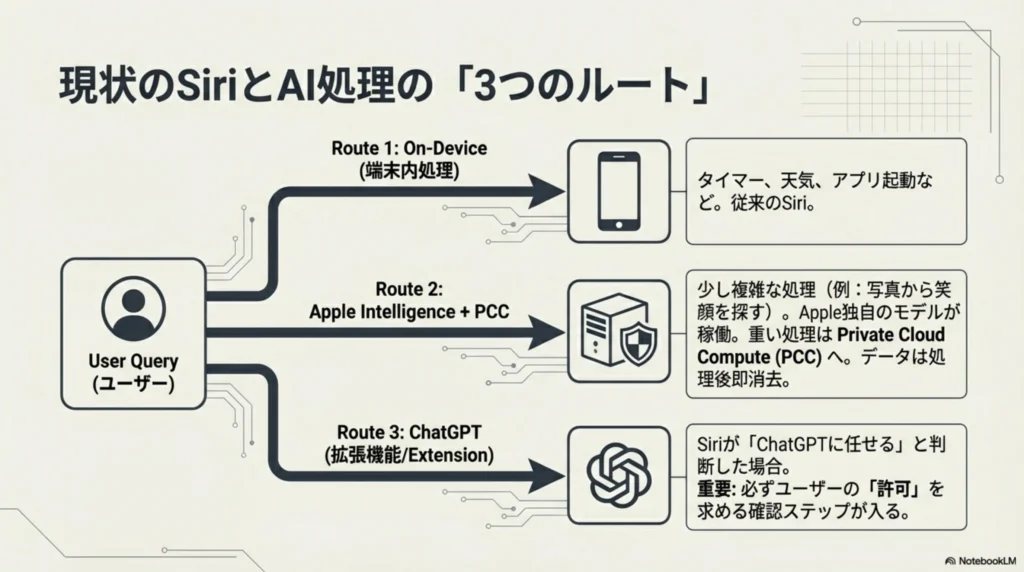

Siriの処理は大きく分けて次の3系統があります。

- 従来のSiri機能で完結(端末内処理や既存のSiri機能で実行)

- Apple Intelligence(Appleの生成モデル)で処理

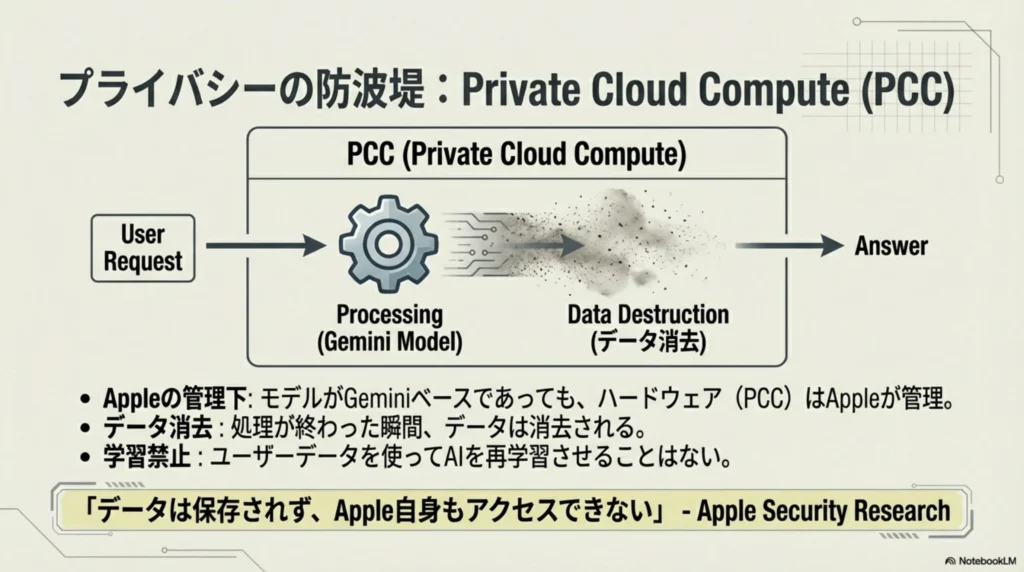

端末内でできない重い生成処理は、必要に応じて Private Cloud Compute(PCC) を使う。

(Apple側でもユーザーデータを保持しない設計) (Apple Security Research) - 外部モデル拡張としてChatGPTを利用

Siriが「ChatGPTが役に立つ」と判断したり、ユーザーが明示的に頼むと、ChatGPT拡張へ渡す (Apple サポート)

あなたが見ている「ChatGPTが答えた」ケースは、主に③です。

2) いつSiriからChatGPTに切り替わる?

代表的にはこの2パターンです。

A. ユーザーが明示的に指定する

「ChatGPTに聞いて(Ask ChatGPT)」のように言うと、SiriはそのままChatGPT拡張へ投げられます。 (Apple サポート)

B. Siriが提案して確認する

Siriが「この質問はChatGPTが得意」と判断すると、“ChatGPTを使っていい?” の確認が出ます。写真やファイルを送る場合は必ず確認されます。 (Apple サポート)

3) どんなデータがChatGPT側へ送られる?

Appleサポートの説明だと、ChatGPT拡張を使うときは:

- あなたの質問(テキスト/音声からの内容)

- 添付(写真・ファイルなど)

- それに加えて、回答精度や不正利用対策のための 限定的な付随情報(例:タイムゾーン、国、デバイス種別、言語、どの機能から呼ばれたか等)

が送られます。 (Apple サポート)

さらに重要ポイントとして:

- IPアドレスはChatGPT側からは“隠される”(ただし不正対策や法令対応のための 大まかな位置情報 は提供される) (Apple サポート)

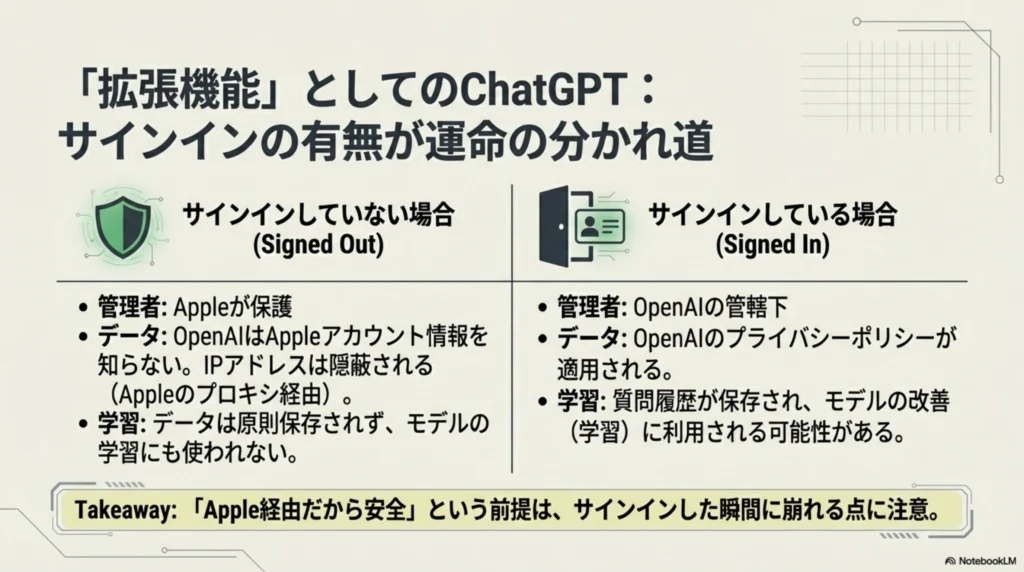

4) 「サインインする/しない」で扱いが変わる(超重要)

ChatGPTアカウントに サインインしない 場合

- OpenAIは Appleアカウントに紐づく情報を受け取らない

- 原則として保存しない/学習に使わない(法令で必要な場合を除く)

という条件が明記されています。 (Apple サポート)

ChatGPTアカウントに サインインする 場合

- OpenAI側のプライバシーポリシーと、あなたのChatGPT側の設定が適用される

- その結果、リクエスト/添付/履歴がログされ、学習や改善に使われ得る(設定次第) (Apple)

つまり「Siriで使っているつもり」でも、サインインしているかどうかでデータの扱いは別物になります。

5) 設定でコントロールできること

iPhoneでは概ね次の場所で設定します:

設定 → Apple Intelligence & Siri →(Extensions)ChatGPT (Apple サポート)

できること(代表):

- ChatGPTを有効/無効

- 毎回確認(Confirm ChatGPT Requests) をオン/オフ

※ただし 写真/ファイル送信は常に確認 (Apple サポート) - アカウントで使う/使わない(サインイン)

- スクリーンタイムで拡張機能のアクセス制限 (Apple サポート)

6) Private Cloud Compute(PCC)との違い(混同しやすい)

- PCC:Appleの生成モデルを“Apple管理のクラウド”で実行する仕組み。端末→PCCノードへ暗号化し、処理後はデータを保持しない設計で、Apple側でも閲覧できないことを目標にしている (Apple Security Research)

- ChatGPT拡張:OpenAI側のモデルに問い合わせる。上のとおり サインイン有無でデータ扱いが変わる (Apple)

7) 使い分けの実務的な目安

- 個人情報が絡む(氏名、住所、取引、社内資料など)

→ まずは ChatGPTに送らない前提(確認オン、添付しない、必要ならChatGPT拡張をオフ) - 一般知識・文章のたたき台・要約

→ ChatGPT拡張が便利(ただし機微情報は避ける) - 保存や高度なモデルが必要

→ サインイン(ただしChatGPT側のデータ設定も確認) (OpenAI Help Center)

参考:今後の変化の可能性

直近の報道では、Appleが将来のSiri強化でGoogleのGeminiモデル統合に動く可能性も伝えられています(2026年中の話として報道)。この場合でも「必要に応じて外部モデルへ委譲」という大枠は似た形で続く可能性があります。 (Reuters)

現状のSiriとGeminiとの関係

今後、Geminiが外部LLMとなるようですが、現在のChatGPTと同じ扱いになるということですか

ChatGPT 5.2 Thinkingの回答

了解です。Appleが外部LLMとしてGeminiを扱う場合の「仕組みの共通点」と「変わりうる点(アカウント連携・ログ/学習・送信データ・確認UI)」を、最新報道とAppleの公式方針から突き合わせて整理します。

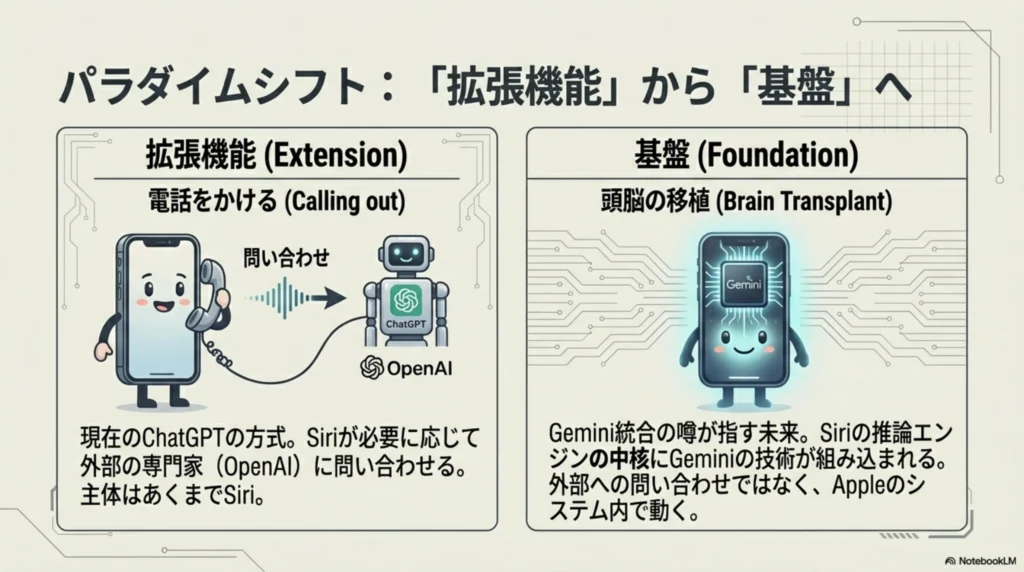

結論から言うと、「ChatGPT拡張(Extension)とまったく同じ扱いになる」とは、現時点では断言できません。

理由は、いま公式に示されている「Geminiの入り方」が、ChatGPT拡張とは 別タイプ だからです。 (blog.google)

まず整理:ChatGPTは「外部LLM拡張」として動いている

いまのChatGPT連携は、Appleの設定にも明確に Extensions > ChatGPT として出てくる「拡張機能」です。

(Appleサポート)

- Siriが「ChatGPTに回すべき」と判断、またはあなたが「ChatGPTに聞いて」と明示

- 送る前に確認(確認を省略する設定もあるが、ファイル送信は常に確認) (OpenAI Help Center)

- サインインしない利用だと、OpenAI側は「IPアドレスを受け取らない/保存しない/学習に使わない」と説明

(OpenAI Help Center)

(サインインすると、OpenAI側のポリシーとあなたの設定が効く) (Appleサポート)

今回のGeminiは、公式発表ベースだと「拡張」よりも深い“基盤側”

GoogleとAppleの共同声明では、Apple Intelligenceは引き続きデバイス上+Private Cloud Compute(PCC)で動作し、Appleのプライバシー基準を維持するとされています。 (blog.google)

さらに報道では、Geminiが「Siri/Apple Intelligenceの基盤(foundation)側を支える」ニュアンスが強く、“外部LLMに投げる拡張”というより、Apple側の処理基盤として使われる可能性が示唆されています。 (The Verge)

ここがポイント

- ChatGPT拡張:必要なときに「外部(OpenAI)へ問い合わせる」導線

- Gemini基盤(とされる方向):Apple Intelligence自体の中核が、Appleのデバイス/PCC上で動く形に寄る

なので、「ChatGPTと同じ“外部LLM拡張扱い”になる」とは限らない、というのが現状のいちばん堅い答えです。

ただし「Gemini拡張」が別途出る可能性はある(未確定)

一部の観測記事では「将来、GeminiがChatGPTのように“拡張”として提供されるかも」という見立てもありますが、これは現時点では推測の域です。 (Daring Fireball)

もし Gemini拡張 が提供されるなら、挙動はかなり似るはずです:

- 「Geminiに送って良いか」の確認UI

- 添付(写真/ファイル)は都度許可

- サインイン有無でログ/学習の扱いが変わる可能性

(その場合はGoogle側のプライバシー条件が絡むので、ChatGPT拡張と同一にはならない可能性が高い)

(Google ヘルプ)

あなたが気にすべきチェックポイント(今後の見分け方)

今後iOS側で次のどちらに当たるかで「扱い」が変わります。

- Apple Intelligenceの処理としてGeminiが使われる(基盤側)

→ Appleのデバイス/PCCで動く前提・Appleのプライバシー設計に寄る (blog.google) - Extensionsに “Gemini” が増える(拡張側)

→ ChatGPT拡張に近い導線。ただしデータ扱いはGoogleの条件も見る必要 (Google ヘルプ)

必要なら、あなたのiPhoneの 「設定 > Apple Intelligence & Siri」 画面のスクショ(Extensions周り)を貼ってください。

それが「基盤としての切替」なのか「拡張としてのGemini追加」なのか、画面上の文言でかなり判別できます。

「GeminiがApple Intelligenceの“基盤(Apple側で運用)”として使われるというのは、SiriのAIモデルとして、GeminiのAIモデルと同じものが使われるということであり、その状態では、AIモデルはApple内にあり、外部に情報が出ている状態ではないということですか

ChatGPT 5.2 Thinkingの回答

概ねあなたの理解は 方向としては合っています。ただし「外部に情報が出ていない」の“外部”が どこを指すかで答えが変わります。

まず前提:今うわさ/発表されている“Geminiの入り方”は2通りあり得ます

A) Apple Intelligenceの基盤として、Apple運用(オンデバイス+Private Cloud Compute)

GoogleとAppleの共同声明では「Apple Intelligenceは今後も Appleデバイス上 と Private Cloud Compute(PCC) で動作し、Appleのプライバシー基準を維持する」とされています。 (blog.google)

この形だと、あなたの言う「モデルがApple側の環境で動く」にかなり近くなります。

- オンデバイス:入力データは端末内で完結(ネットに出ない)

- PCC:入力データは AppleのPCCサーバへ送られる(=端末の外には出る)が、Appleは「データは保存されず、Appleにもアクセスできず、要求を満たすためだけに使う」と説明しています。 (Appleサポート)

さらに「PCCで動くコードは独立研究者が検証できる」とも説明しています。 (Appleサポート)

👉 つまりAの場合は、(少なくとも公式説明の範囲では)Googleなど“第三者”にあなたの入力が渡る形ではない、という整理になります。

ただし PCCを使う限り、端末→Appleクラウドへは出ます(“端末の外”には出る)。

B) ChatGPT拡張のように「外部LLM拡張」としてGeminiへ問い合わせる

この形だと、入力(質問文・添付など)はGemini(Google側)に送られます。ChatGPT拡張がまさにこれで、Appleも「拡張を使うと外部サービスに情報が送られる」前提で、確認UIや送信内容の説明を用意しています。 (Appleサポート)

👉 Bの場合は、あなたの言う「外部に情報が出ていない」には当たりません。

あなたの質問への答え(言い換え)

「基盤としてApple側で運用」=「Geminiと同じモデルがSiriのAIモデルとして使われ、モデルはApple内にあり、外部に情報が出ない」?

- “第三者(Googleなど)に情報が出ない”という意味なら、Aの設計であればその方向です(共同声明の文脈もその方向)。 (blog.google)

- ただし “端末の外に一切出ない”という意味なら、それは オンデバイスで完結する場合に限る ので、PCCが関与する処理では 端末→Appleクラウドへは出ます。 (Appleサポート)

見分け方(実務的)

今後Geminiが来たとき、次を見れば判断しやすいです。

- 設定の Apple Intelligence & Siri に 「Extensions(拡張)」としてGemini が現れる

→ B(第三者に送る)の可能性が高い - 拡張の項目がなく、Apple Intelligenceの通常機能として動く/PCCの説明が付く

→ A(Apple運用)寄りの可能性が高い (Appleサポート)

AppleのAIモデル(元Gemini)と、GoogleのGeminiは、今後、別々のデータを学習し、同じ質問をしても、回答は違うものになるということですか

ChatGPT 5.2 Thinkingの回答

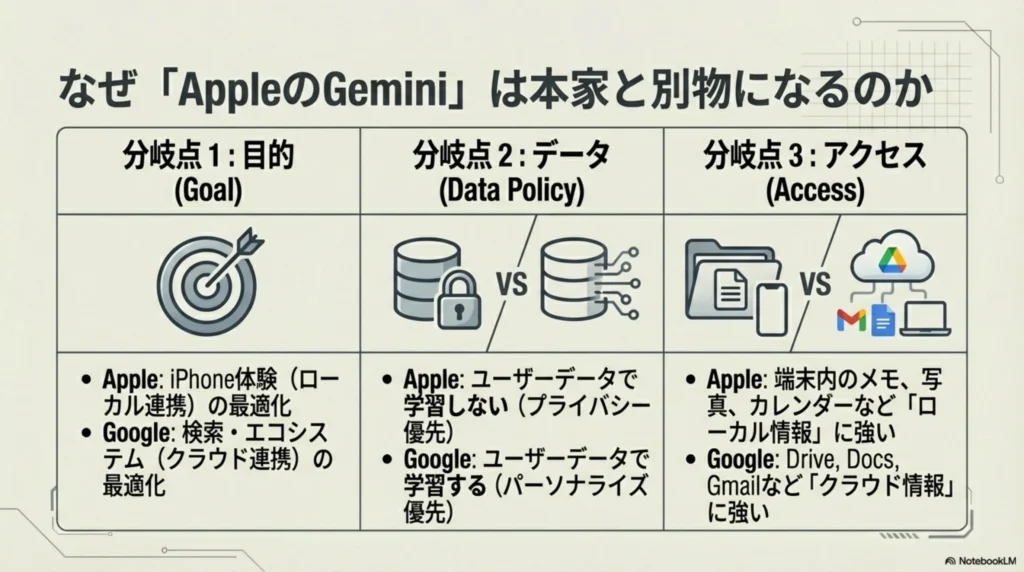

はい、(たとえ出発点が同じ系統のモデルでも)将来的には別物として進化して、同じ質問でも回答がズレる可能性が高いです。

ただし、現時点で「Appleのモデルが“Geminiそのものの重み”なのか」「Geminiの技術を土台にAppleが別モデルを作るのか」などの実装詳細は公開されていないので、確度は「高い見込み」までになります。 (Google Blog)

なぜ回答が違っていく可能性が高いのか

1) 学習・チューニングのデータと目的が別になる

共同声明では、Googleの技術が「Apple Foundation Modelsの基盤」になる、と表現されていますが、Apple Intelligenceは引き続きオンデバイス+Private Cloud Compute(PCC)で動作し、Appleのプライバシー基準を維持するとされています。 (Google Blog)

この時点で、Apple側は「Apple向け体験」に最適化する方向になり、GoogleのGemini(Google製品・エコシステム最適化)とは最適化目標がズレやすいです。

2) “学習させない”方針が違いを生む

AppleはPCCを含むApple Intelligenceについて、データは保存されずAppleにもアクセスできないという設計を強く打ち出しています。 (Apple Security Research)

仮にAppleが「ユーザーデータを学習に使わない」方針を維持するほど、Google側(Gemini)とは改善の材料(ログ・フィードバック・訓練データの取り込み方)が異なり、長期的に差が出やすくなります。 (Apple)

3) そもそも“同じモデル”でも、運用(システム/安全/ツール)で答えは変わる

同じ基盤モデルでも、最終出力は次で大きく変わります:

- システムプロンプト(性格・方針・禁止事項)

- 安全フィルタ/ポリシー

- 使えるツール(端末内の予定・写真・設定にアクセスできる、Web検索ができる、Googleサービスに繋がる等)

- 取得できるコンテキスト(Apple側は端末/OS文脈、Google側はGoogleアカウント文脈…など)

Apple IntelligenceはオンデバイスやPCCという枠の中で動かす前提が明確なので、GoogleのGemini(Google側のクラウド/連携)とはツールと文脈が別物になり、同じ質問でも回答が変わり得ます。 (Google Blog)

“いつ”ズレが目立つ?

ズレが出やすいのは例えば:

- 個人文脈が絡む質問(「今日の予定に合わせて…」「この写真の…」など)

→ Apple側は端末文脈、Google側はGoogle側文脈で強みが違う - 最新情報が必要な質問

→ どの検索/情報源に繋がるかで差が出る - グレーな領域(医療・法律・金融・安全)

→ ポリシー差で言い方や結論が変わる

まとめ(あなたの問いへの答え)

- はい:Apple側(Apple Intelligenceの基盤として運用される“Appleのモデル”)と、GoogleのGeminiは、別々のデータ・別々の最適化・別々の運用で進化していく可能性が高く、同じ質問でも答えが違っていくと考えるのが自然です。

(Google Blog) - ただし、「Appleのモデル=Geminiの重みそのもの」なのかは未公開なので、現段階では「差が出る構造になりやすい」という整理になります。 (Google Blog)

ChatGPT 5.2 Thinkingに、「Geminiが外部LLMとなるようですが」と質問してしまったため、GeminiがExtensions(拡張)」として働く場合についても、ChatGPT 5.2 Thinkingは言及したが、どうやら、Apple Intelligenceの基盤として、オンデバイス+Private Cloud Computeで運用されるということのようだ。

ただし、Siriがユーザーの了解のもと、Geminiなどの外部に情報を送り、Siriの能力がさらに向上する(Google Mapなどのアプリも扱えるようになるなど)なら、そのようなルートの併用もありかもしれない。現在でも、CarPlayでGoogle Mapの呼び出しはできるので。

Appleがユーザーデータを使わない方針を維持すると、ユーザーの状況・要求が分からないAI(ユーザーフレンドリーでないAI)になってしまい、時代の流れに逆行することになるのでは。

以降は、現在のSiriができること、扱えるアプリを整理し、それらにどのような変化がある可能性があるかを探っていく。

現状のSiriにできること

AppleのSiriが、現状、できることを全て詳細に回答してください

ChatGPT 5.2 Thinkingの回答

目的:2026年1月時点のSiriの機能を「できること/できない・制約/環境別(iPhone・Mac・HomePod・CarPlay)」で漏れなく整理します。手順:①Apple公式のSiriガイドや機能ページをWebで確認→②主要カテゴリ(操作・検索・コミュニケーション・メディア・スマートホーム等)に分解→③日本語環境の注意点も添えて一覧化します。

いま公式ドキュメント(iPhone/iPad/Mac/Watch/HomePod/CarPlay)で「Siriでできること」のカテゴリを洗い出し中です。次にApple Intelligence連携で追加されたSiri体験(入力・文脈保持など)も整理して統合します。

以下は2026年1月時点の「Siriが“できること”」を、機能カテゴリ × 端末別 ×(Apple Intelligenceの有無)で、抜けが出にくい形に整理した一覧です。

※Siriは 言語・国/地域・端末・OS・アプリ対応状況でできる範囲が変わります。 (Appleサポート)

1) Siriの起動・入力方法(共通)

- 声で起動:「Hey Siri」または「Siri」 (Appleサポート)

- ボタンで起動:端末/アクセサリごとのSiriボタン(例:CarPlayの音声ボタン長押し等) (Appleサポート)

- タイプ入力(Type to Siri):声を出せない場所で、Siriに文字入力できる (Appleサポート)

2) 情報の取得(調べもの・計算・翻訳など)

- Web検索ベースの質問、計算、スペル、翻訳などをSiriに頼めます (Appleサポート)

(例:天気、単位換算、一般知識の確認、簡単な計算 など)

3) 通話・メッセージ・メール(連絡系)

- 電話/FaceTimeの発信

- メッセージ送信

- メール送信

など、コミュニケーション系アプリ操作を音声で実行できます (Appleサポート)

4) 音楽・ポッドキャストなどの再生コントロール

- iPhone等で ミュージック/ポッドキャスト再生、停止、一時停止、スキップなど (Appleサポート)

- HomePodでは 再生・マルチルーム制御・ニュースを聴くなど、オーディオ中心の操作をSiriでできます (Appleサポート)

5) Appleデバイス本体の操作(端末設定・基本操作の一部)

- iPhoneや他のAppleデバイスを声でコントロール(一部設定の切替等)

- スマートホームアクセサリも含めて操作できる (Appleサポート)

6) ナビゲーション(車・徒歩・経路・ETA)

- 経路検索、交通情報、到着予定時刻(ETA)の共有、近くの場所検索など (Appleサポート)

- CarPlayではSiriで操作でき、車種によってはハンドルの音声ボタン長押し等で起動できます (Appleサポート)

7) “アプリの中の操作”をSiriで実行(アプリ対応が前提)

- Siriに「アプリのアクション」を頼んでタスクを完了できます(例:買い物リストに追加など) (Appleサポート)

- ただし、他社アプリ側がSiri対応(ショートカット/アプリ連携)している必要があります (Appleサポート)

8) スマートホーム(Apple Home / HomeKit / Matter等)

- 照明、エアコン、温度、鍵、カメラ等をSiriで操作(在宅/外出先) (Appleサポート)

- Apple TV 4Kでは、Apple Home製品の制御や状態確認、シーン起動などをSiriで行えます (Appleサポート)

- ホームのオートメーションは、条件(時刻・位置・センサーなど)で実行可能。Thread系はホームハブ要件が出る場合があります (Appleサポート)

9) Siriショートカット(Shortcuts)でできることが“ほぼ無限に増える”

- Siriで ショートカットを音声起動(iPhone/Watch/HomePod等、複数デバイスから起動可能) (Appleサポート)

- 他社アプリに「Siriに追加」ボタン等があれば、そのアプリ操作をショートカット化してSiriで実行 (Appleサポート)

10) 端末別:Siriでできることの“得意分野”

iPhone / iPad

- 調べもの、連絡、メディア、スマートホーム、ナビ、アプリ操作、Apple Intelligence連携 (Appleサポート)

Mac

- 調べもの、連絡(電話/メッセージ/メール)、メディア、スマートホーム、アプリ操作など (Appleサポート)

Apple Watch

- Watch上でタスク実行や質問への回答表示など (Appleサポート)

HomePod

- 音楽/ニュース/マルチスピーカー制御など“音声中心”が強い (Appleサポート)

Apple TV

- 見たい作品の検索(タイトル/ジャンル/出演者など)、Apple TV 4KではHome制御も (Appleサポート)

CarPlay

- 運転中の音声操作が中心。Siriで次の行動提案なども (Appleサポート)

11) Apple Intelligence連携で“Siri体験”が変わる部分(対応端末のみ)

Apple Intelligenceが使える環境では、Siriが次のように強化されます:

- 新しいSiri表示(iPhone/iPad/CarPlayで画面の縁が光る等) (Apple)

- 話し言い直しに追従(途中で言い直しても意図を理解して実行) (Appleサポート)

- 文脈を保って連続リクエスト(会話をつなげやすい) (Apple)

- タイプ入力と音声の切替がスムーズ (Apple)

- Apple製品の使い方(製品知識)に答える (Appleサポート)

- 必要に応じてChatGPTを呼び出して回答を拡張(許可制・拡張機能) (Appleサポート)

※Apple IntelligenceはすべてのiPhoneで使えるわけではなく、言語/地域/機種/OSで差があります (Appleサポート)

12) プライバシー面(“できること”に直結する注意)

- Siri処理のために、音声・設定情報・連絡先・位置情報などがAppleに送信される場合がある

(設計上はApple Accountに紐づけない説明) (Apple) - 「改善に協力」をオンにすると、音声や文字起こし等がレビュー対象になる場合がある/設定変更や履歴削除の手段が用意されている (Apple)

13) “できない/苦手になりやすい”典型パターン(現状の限界)

- 他社アプリの深い操作:アプリ側がSiri/ショートカット対応していないと実行できない (Appleサポート)

- 言語・地域差:同じSiriでも国/地域・言語で機能差が出る (Appleサポート)

- Apple Intelligence前提の高度な体験:対応機種・OS・設定が必要 (Appleサポート)

- 許可が必要なもの:連絡先、位置情報、Home操作、ChatGPT拡張などは権限/設定次第で制限されます (Apple)

すぐ試せる“網羅チェック”のコツ

iPhoneでは、Siriに 「ここで何ができる?」 と聞くと、その場で追加例が出るように案内されています (Appleサポート)

(端末/設定/言語に依存して出る例が変わるので、実機の範囲確認に向きます)

直近の動向(参考)

Siriの今後の大型強化について、AppleがGoogleのGeminiを採用する方向で進めている、という報道も出ています。

(“現状”ではなく将来計画の話) (The Verge)

Apple Intelligenceによって、現状でも、話し言い直しに追従(途中で言い直しても意図を理解して実行)できたり、文脈を保って連続リクエスト(会話をつなげやすい)ができるとなっている。

性能が高くなっても、許可が必要など、色々と制限がありそうだ。

現状のSiriが操作できるアプリ

AppleのSiriが操作できるアプリを具体的に全て分類して回答してください

ChatGPT 5.2 Thinkingの回答

結論から言うと、「Siriが操作できる“アプリ全部”」を世界中のアプリ名で完全列挙する公開リストはありません(対応/非対応が更新され続け、端末に入っているアプリにも依存します)。

一方で “操作できるアプリの分類(仕組み・領域)”は全て整理でき、さらにあなたの端末上で“全件(インストール済み)”を確認する方法もあります。 (Appleサポート)

1) Siriがアプリを操作できる「3つの経路」=分類の全体像

A. OSに組み込まれた標準アプリ操作(Apple純正中心)

電話・メッセージ・メール・音楽・地図・リマインダー等、Siriが“標準で”深く操作できる領域。 (Appleサポート)

B. ショートカット(Shortcuts)経由のアプリ操作

アプリが「ショートカットのアクション」を提供していれば、Siriでそのアクションを実行できます。

(例:アプリで○○を追加/開始/記録)。 (Appleサポート)

C. 開発者実装(App Intents / App Shortcuts / SiriKit)によるアプリ操作

アプリ側が App Intents(現行の推奨)や SiriKit(旧来)を実装していると、Siri/ショートカット/提案/Spotlightなどからアクション実行が可能になります。 (Apple Developer)

※Appleは「SiriKit+Siri Shortcutsで動くアプリが15,000以上」と言及しています(ただし“名称一覧”の公開ではありません)。 (Apple Developer)

2) 「操作できるアプリ」を“具体的に”分類(ドメイン別)

下記は Siriがアプリ操作に使う代表的な機能ドメインです(=どの種類のアプリがSiri操作に乗りやすいか)。

2-1. コミュニケーション

- 電話/通話系(標準の電話 + VoIP通話アプリ)

- メッセージ系(メッセージアプリ、チャットアプリ)

SiriKitには Messaging / VoIP Calling としてドキュメント化されています。 (Apple Developer)

2-2. リスト・メモ(生産性)

- ToDo/買い物リスト/タスク管理

- メモ/ノート

SiriKitの Lists and Notes ドメイン。 (Apple Developer)

2-3. メディア

- 音楽/音声(音楽ストリーミング、ポッドキャスト等)

SiriKitの Media ドメイン。 (Apple Developer)

2-4. 写真

- 写真検索/表示(写真管理系)

SiriKitの Photos 系の考え方。 (Qiita)

2-5. フィットネス

- ワークアウト開始/停止/記録(フィットネス・トラッカー等)

SiriKitの Workouts。 (Apple Developer)

2-6. 移動・ナビ/配車

- 地図・経路・ETA(標準マップ中心、ショートカット経由も多い)

- 配車アプリ(Ride Booking)

SiriKitの Ride Booking。 (Apple Developer)

2-7. 支払い(地域・提供状況依存)

SiriKitの Payments(ただし国/地域やサービス提供に強く依存)。 (Apple Developer)

2-8. スマートホーム

- Home(ホーム)アプリとHome対応デバイスの操作(照明、エアコン、鍵など)

Siriの標準機能として案内されています。 (Appleサポート)

3) Apple純正「Siriで操作できる」代表的な標準アプリ(具体名)

Appleのガイドで明示される“中核”は以下です(この範囲はSiriが最も安定して深く操作します)。 (Appleサポート)

- 電話 / FaceTime

- メッセージ

- メール

- ミュージック / ポッドキャスト

- マップ

- リマインダー

- メモ

- ショートカット

- ホーム(Home)

※このほかにも、タイマー/アラーム等の“システム機能”はSiriで広く扱えますが、ここでは「アプリ操作」に絞って列挙しています。 (Appleサポート)

4) 「第三者アプリを含めて“全て”」を実機で確認する方法(ここが最重要)

あなたのiPhoneに入っている **Siri操作対応アプリの“全件”**は、次の2か所で確認できます。

方法1:設定で、アプリごとのSiri/検索/提案の対象を一覧で見る

「設定」→(Siri/Apple Intelligence関連)→ 検索(Search) の中で、下へスクロールするとアプリが並び、アプリ単位でオン/オフを調整できます。 (Appleサポート)

方法2:ショートカットで「アクション提供しているアプリ=Siri操作できる可能性が高いアプリ」を全件見る

「ショートカット」アプリで アクション追加を開くと、インストール済みアプリが提供するアクションが一覧化されます(=Siriで実行できる形に落とし込みやすい)。 (Appleサポート)

5) 注意:SiriKitの一部ドメインは“非推奨/廃止”がある

SiriKitの intent domains の一部は iOS 15以降で段階的に非推奨/廃止になり、古い統合は効かなくなる場合があります。いま新規/現行で主流なのは App Intents 側です。 (Apple Developer)

性能が高くなっても、扱えるアプリが純正に限定されると、活用機会が制限される。手足となる外部アプリとの連携を望みたい。

Geminiと同じAIモデルが、Siriの既存のアプリに与える影響

Siriが扱えるアプリのうち、今後、Geminiと同じAIモデルが、専用クラウド基盤「Private Cloud Compute(PCC)」で動作するようになった場合、現状扱えるアプリにどのような影響を与える可能性がありますか

ChatGPT 5.2 Thinkingの回答

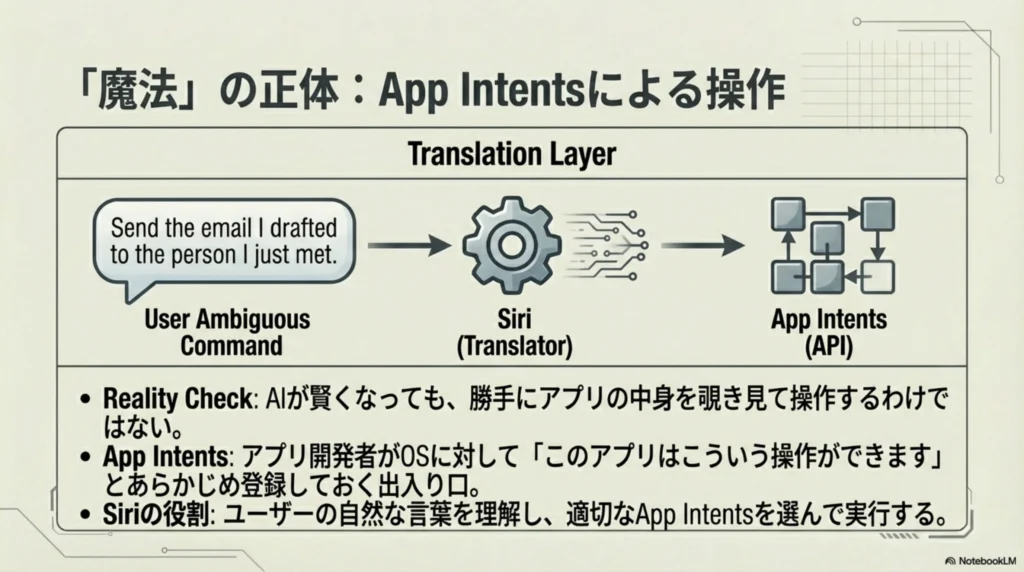

起こり得る変化は大きく言うと 「(1) “理解・計画”が強くなる」一方で、「(2) “実行できるアプリの範囲”そのものは急には増えにくい」です。理由は、Siriがアプリを操作する“出口”が基本的に App Intents(やショートカット)で決まるからです。 (Apple Developer)

質問:App Intentsとは何ですか。簡単に説明してください。

ChatGPT 5.2 Thinkingの回答:

App Intentsは、アプリが持っている機能(例:検索、登録、再生、記録など)を「このアプリはこういう操作ができる」とOSに宣言して、Siri/ショートカット/Spotlight などのシステム機能から呼び出せるようにする仕組みです。

イメージとしては「アプリの操作メニューを、OS(Siriやショートカット)が理解できる形で提供するAPI」です。これにより、ユーザーは音声やショートカットのアクションとして、その操作を実行できます。

1) 前提:Gemini相当モデルが「PCCで動く」とは何が違う?

- Apple Intelligenceは「端末内でできるか」を判定し、難しい処理は Private Cloud Compute(PCC)に回す設計。

PCCでは“必要最小限のデータ”だけを処理し、処理後に除去する、と説明されています。 (Appleサポート) - 2026年1月のGoogle×Apple共同声明でも、「Apple Intelligenceはデバイス上+PCCで動き続ける」旨が示されています。 (blog.google)

→ つまり「外部のGeminiサービスに投げる」のではなく、AppleのAI実行基盤(PCC)側で、より大きい/強いモデルが動くイメージです。

2) “扱えるアプリ”に起きやすい変化(可能性が高い順)

2-1. 既に対応しているアプリが「より自然な指示で動く」

Siriが同じアプリ(同じIntent/ショートカット)を動かすとしても、モデルが強くなると次が改善しやすいです。

- 言い回しの揺れ・省略・言い直しへの耐性が上がり、失敗が減る

- 曖昧さの解消(どの“田中”に送る?どの“会議”?)がうまくなる

- 「条件+目的」をまとめた指示(例:“到着が遅れそうなら到着予定時刻も添えて送って”)をより正確に分解できる

※実行自体はApp Intents/ショートカットに沿って行うため、効果が最も出るのは「対応済みアプリ」。 (Apple Developer)

2-2. “複数アプリまたぎ”が増える(ただし実行面の制約は残る)

強いモデル+PCCで、Siriが「計画(planner)→実行(actions)」を作りやすくなると、例えば

- メール要約→予定作成→関係者に送信

- メモ/ToDo登録→カレンダーにブロック→移動時間を見て通知

のようなクロスアプリの連鎖は増え得ます。

ただし、ここでも“実行”は 各アプリのApp Intents(またはショートカット)が提供している範囲に縛られます。

(Apple Developer)

2-3. 「対応アプリ数」が増える可能性(増え方は“開発者次第”)

App Intentsは、アプリが自分の機能をSiri/Spotlight/Shortcuts/Apple Intelligenceに“公式に公開”する枠組みです。

(Apple Developer)

モデルが強くなるほど、Appleは「アプリ側はIntentを出しておけば、ユーザーが自然文で呼べる」体験を作りやすいので、

- サードパーティがApp Intents対応を進める

- AppleがOS側で “このカテゴリのIntentを実装するとSiriでここまでできる”のガイド/誘導を強める

といった形で、結果として「Siriで扱えるアプリ」が増える可能性はあります。

(ただし“自動で全部のアプリが操作できる”にはなりません) (Apple Developer)

3) “扱えるアプリ”が急には増えにくいポイント(現実的な上限)

3-1. アプリ操作の“出口”は基本、App Intents/ショートカット

モデルがどれだけ賢くなっても、OSが許す安全な方法でしか他アプリを動かせません。

そのため 「対応していないアプリを、勝手に深い操作までやる」方向には行きにくいです。 (Apple Developer)

3-2. 権限・確認(プライバシー/安全)フローは残る可能性が高い

PCCは“必要データだけ処理して除去”という設計ですが、機密に触れる処理はユーザー確認が残りやすいです。

(Appleサポート)

(ChatGPT拡張でも、送信前の確認や、写真/ファイル送信時の確認がある設計が示されています。GeminiがPCCで動く場合も、同様に“確認の設計”が残る可能性があります。) (Appleサポート)

4) 具体的に起こり得る「変化の例」

- 純正アプリ(電話/メッセージ/メール/マップ/リマインダー等)

→ できること自体よりも、成功率・意図理解・複合指示の処理が上がる方向が濃厚。 (Appleサポート) - 対応済みサードパーティ(App Intents/ショートカットが豊富なアプリ)

→ “言い方”が増える、提案が賢くなる、アプリ横断が増える。 (Apple Developer) - 未対応アプリ

→ “知識として答える”はできても、直接操作できるようにはならない可能性が高い(開発者の対応待ち)。 (Apple Developer)

5) まとめ:変化は「アプリ数が激増」より「使えるアプリが賢くなる」

- PCC上でGemini級モデルが動くと、Siriの“理解・計画・文脈処理”が強化され、既存の対応アプリはより自然に扱えるようになる可能性が高い。 (Appleサポート)

- 一方で「Siriが扱えるアプリの範囲」を決めるのは App Intents/ショートカットの提供状況なので、未対応アプリが一気に操作可能になるタイプの変化は起きにくい。 (Apple Developer)

Siriが、GmailやGoogleカレンダーやGoogle Mapを扱えるようになる可能性

Siriが、GmailやGoogleカレンダーやGoogle Mapを扱えるようになる可能性はありますか。

また、扱えるようになるには、どのような条件が必要ですか

ChatGPT 5.2 Thinkingの回答

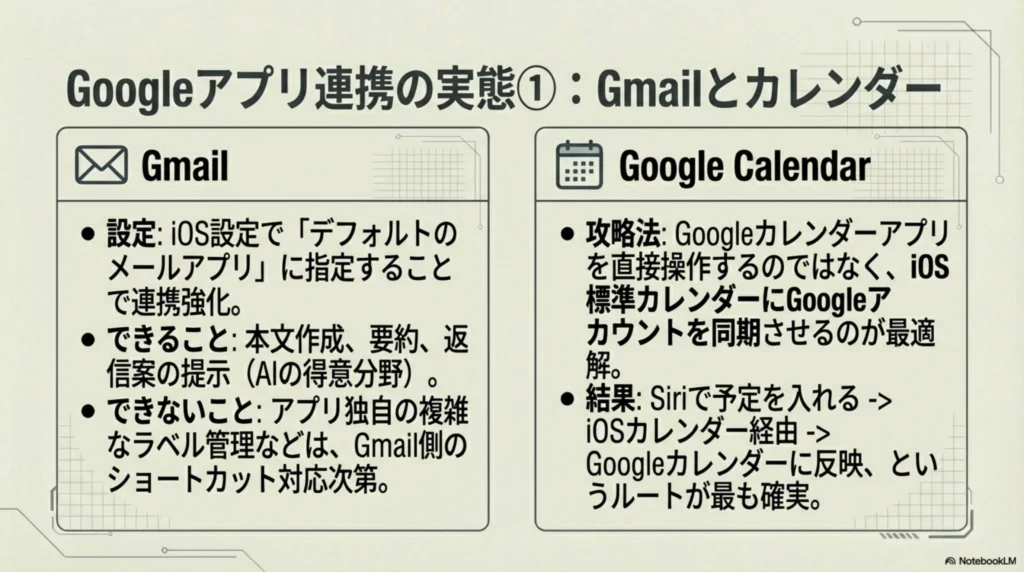

はい、可能性はあります。ただし「Siriが“何でも”Googleの各アプリを自由に操作できる」方向ではなく、現実的には (A) iOSの既存の“デフォルトアプリ機能” と (B) ショートカット / App Intents(アプリ側の対応) の2本立てで広がっていく形になります。 (Appleサポート)

1) GmailをSiriが扱える可能性と条件

起きやすい形(すでに現実的)

- Gmailを“デフォルトのメールアプリ”に設定できる(iOS側が対応しており、アプリ側も対応している必要あり)。

(Appleサポート) - Google自身も、GmailなどのGoogleアプリに Siri Shortcuts対応を追加したと案内しています。 (blog.google)

「扱えるようになる条件」

- iPhoneで 設定 →(アプリ)→ デフォルトアプリ → Email でGmailを選べる状態(= iOSが対応+Gmailが対応)

(Appleサポート) - Gmail側がApp Intents / ショートカット用アクションを提供していること(アプリが提供する範囲だけSiriが実行できます) (Apple Developer)

- 端末側で Siriの許可(Siri検索・提案 等)がオフだと、呼び出しが弱くなることがあります(アプリごとのSiri設定)。 (Appleサポート)

期待できる進化:Gemini級モデルがPCC上で動くようになっても、「メール本文の作成・要約・返信案」は賢くなりやすい一方、“送信/下書き/ラベル”などの実行はGmailが提供するアクション次第です。 (Apple Developer)

2) GoogleカレンダーをSiriが扱える可能性と条件

いちばん確実に“今日から”できる形(Googleカレンダーに入る)

Siriは「Googleカレンダー“アプリ”」を直接操作できなくても、

iPhoneのカレンダーにGoogleアカウントを追加して、デフォルトのカレンダーをGoogle側にしておけば、Siriで作った予定がGoogleカレンダーに入ります(同期される)。 (Appleサポート)

条件

- 設定 → アプリ → カレンダー → カレンダーアカウントでGoogleを追加 (Appleサポート)

- 設定 → アプリ → カレンダー → デフォルトのカレンダーでGoogleのカレンダーを選択 (Appleサポート)

Googleカレンダー“アプリ”をSiriで直接動かすには?

それは Googleカレンダー側が App Intents(App Shortcuts)を実装して、

「予定作成」「招待送信」「会議リンク作成」などのアクションをSiriに公開する必要があります。 (Apple Developer)

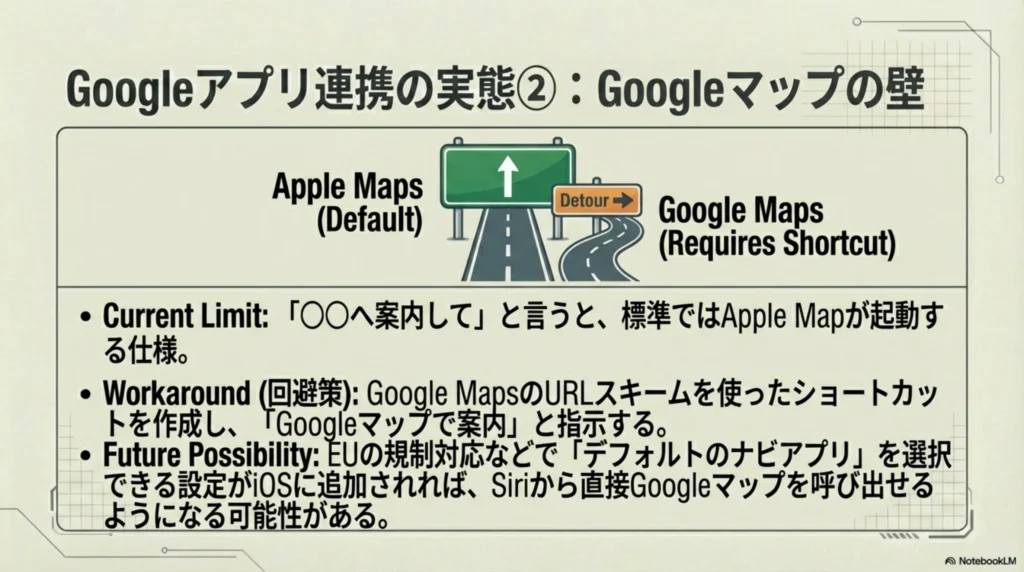

3) Google MapsをSiriが扱える可能性と条件

現実的にできる形(ショートカット/URLで“起動+経路表示”)

Googleは Google Mapsを起動して検索・経路要求などを行うiOS向けURLスキームを公式に提供しています。

これをショートカット化すれば、Siriで「(自作の)ナビ開始」を実現できます。 (Google for Developers)

条件

- Google Mapsがインストールされていること

- ショートカットで Google Maps URLスキームを使う(=Siriはショートカット実行として扱う) (Google for Developers)

「“経路案内して”で常にGoogle Mapsが開く」ようになる可能性

ここはOS側の方針が大きいです。

現状Appleの「デフォルトアプリ」設定は、少なくとも公式ガイド上は メール/通話/メッセージ/ブラウザ/翻訳…などが中心で、ナビアプリの既定化は一般には前提になっていません。 (Appleサポート)

ただし報道ベースでは、EUの規制対応で“デフォルトのナビアプリ選択”が出るといった動きもあり、将来iOS全体に広がれば、Siriの「経路案内」がGoogle Mapsに流れる余地はあります。 (The Verge)

まとめ(可能性の大きい順)

- Googleカレンダー:iOSカレンダーにGoogleを追加+デフォルトをGoogleにすれば、Siri経由でも“結果としてGoogleに入る”のが現実的。 (Appleサポート)

- Gmail:デフォルトメール化+Gmailのショートカット/Intents対応の範囲でSiri操作は増え得る。 (Appleサポート)

- Google Maps:ショートカット(URLスキーム)で“起動+経路”は作れる。OSがナビ既定化を広げれば、Siriの経路案内が直接Google Mapsに行く可能性も。 (Google for Developers)

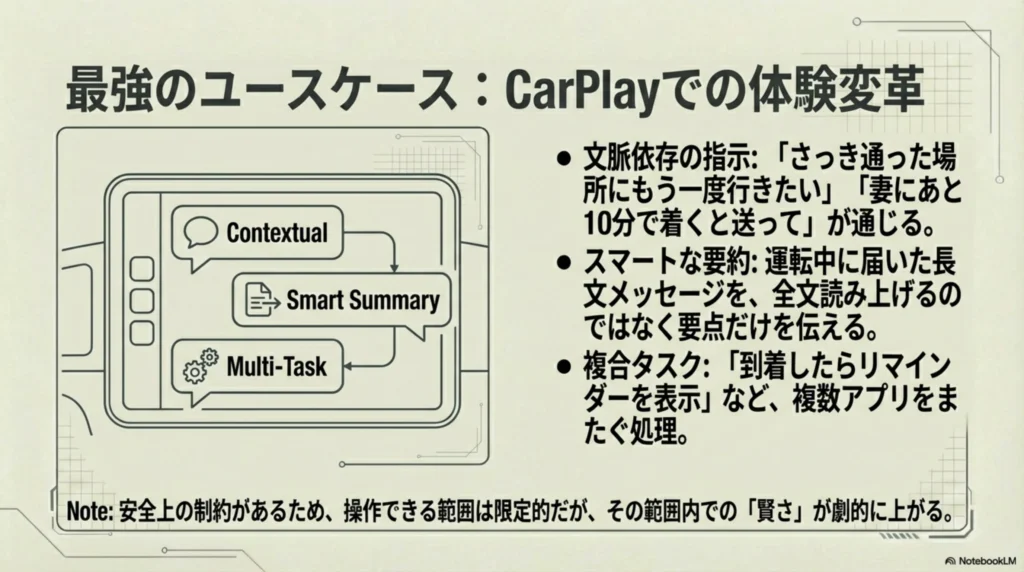

Geminiと同じAIモデルが、Car Playに与える影響

今後、Geminiと同じAIモデルが、専用クラウド基盤「Private Cloud Compute(PCC)」で動作するようになった場合、Car Playにどのような変化の可能性がありますか

ChatGPT 5.2 Thinkingの回答

前提として、CarPlayで「賢くなる」余地は大きい一方、CarPlayで“勝手にできること(アプリ操作範囲)”が無制限に増えるわけではない可能性が高いです。CarPlayは運転中の安全制約が強く、対応アプリ種別も枠が決まっているためです。 (Apple Developer)

その上で、「Geminiと同等の強いモデル」がAppleのPrivate Cloud Compute(PCC)上で動くようになった場合に起こり得る変化を、可能性が高い順にまとめます。

1) CarPlayのSiriが“会話として通る”ようになり、失敗が減る

- 言い直し・省略・曖昧な指示(「さっきの場所に案内して」「あの人に“遅れる”って送って」)の解釈が安定

- 連続指示(「◯◯へナビ→到着予定を共有→メッセージ送信」)が通りやすくなる

- これはAppleがApple Intelligenceで掲げている「Siriがより自然に、柔軟に、システムに深く統合」という方向性と整合します(CarPlayでも新しいSiri UIが示唆)。 (Apple)

2) “運転文脈”に沿った提案・要約が増える(情報提示が整理される)

CarPlayは画面を見せすぎられないので、強いモデル+PCCで次が伸びやすいです。

- 受信メッセージの要点だけ読み上げ(長文を短く、緊急度を推定)

- 目的地候補の絞り込み(「いつもの◯◯」「前に行った駐車場」などの文脈)

- 「次の予定に間に合う?」のような質問に対し、関連情報をまとめて回答(※実際のデータ参照は許可と連携次第)

PCCは「複雑な要求はPCCに回し、リクエストに必要なデータだけを処理して削除」と説明されており、車内で扱いがちな個人情報(連絡先・予定・位置)を前提にした体験を作りやすくなります。 (Appleサポート)

3) CarPlay対応アプリで“できる操作”が増える可能性(ただしアプリ側次第)

CarPlayで使えるアプリ種別は、少なくとも現状は主に次のカテゴリです:

オーディオ/メッセージ&VoIP/ナビに加えて、EV充電・給油・駐車・簡易フード注文・運転タスク系など。

(Apple Developer)

強いモデルが来ると、Siriが「自然文→適切なアクション」に変換する能力が上がるので、

- これらのCarPlay対応アプリが App Intents / Siri対応を拡充

- Appleが「運転タスク」領域の事前学習済みIntentsや推奨実装を増やす

といった形で、“CarPlayで扱える操作”が段階的に増える可能性はあります。Siriとアプリの連携は「Intents(タスク定義)」が基本というのがAppleの立て付けです。 (Apple Developer)

4) ナビ体験の強化(ただし“地図アプリの既定”問題は別)

CarPlayで一番伸びそうなのはナビ周りです。

- 「途中でガソリン/充電したい」「雨を避けたい」「子どもがいるので短時間休憩」など、条件付きの経路相談が通りやすい

- 到着予定の再計算や、予定との整合(遅延時の連絡案作成)など

ただし、「CarPlayの標準ナビがGoogle Mapsに置き換わる」といった話は、OSの既定アプリ方針・地域規制の領域で、モデルが強くなっても自動的に決まるものではありません(別問題)。

5) 変わりにくい点(期待しすぎ注意)

- 対応していないアプリを、Siriが勝手に深く操作できるようにはなりにくい(安全・権限・連携設計の壁)

(Apple Developer) - PCCを使う機能は、通信状況や国/言語/提供条件に左右されやすい(Apple Intelligenceの提供範囲は機種・地域・言語で差が出ます) (Apple)

6) そもそも「Gemini級モデルがPCCで動く」ことの根拠(最近の情報)

AppleとGoogleは、Apple Intelligenceが「端末+PCCで動き続ける」前提で、Geminiを基盤にする旨の共同声明を出しています。 (blog.google)

実用面でいちばん起こりやすい“体感変化”

「CarPlayでSiriに話しかけたときの成功率が上がり、複合指示(ナビ+連絡)が一発で通る」

これがまず最初に効いてくる可能性が高いです。 (Apple)

Geminiの頭脳を持ったSiriに話しかけることになりそうだ。あとは、UIがどのように改善されるかで使い勝手が決まりそうだ。